karminski-牙医

来自 esologic 老哥的新设计, 使用树莓派 pico 作为控制器搭载3个风扇驱动, 可以给服务器用的被动散热显卡使用小风扇进行散热, 可以有效节省机箱空间.

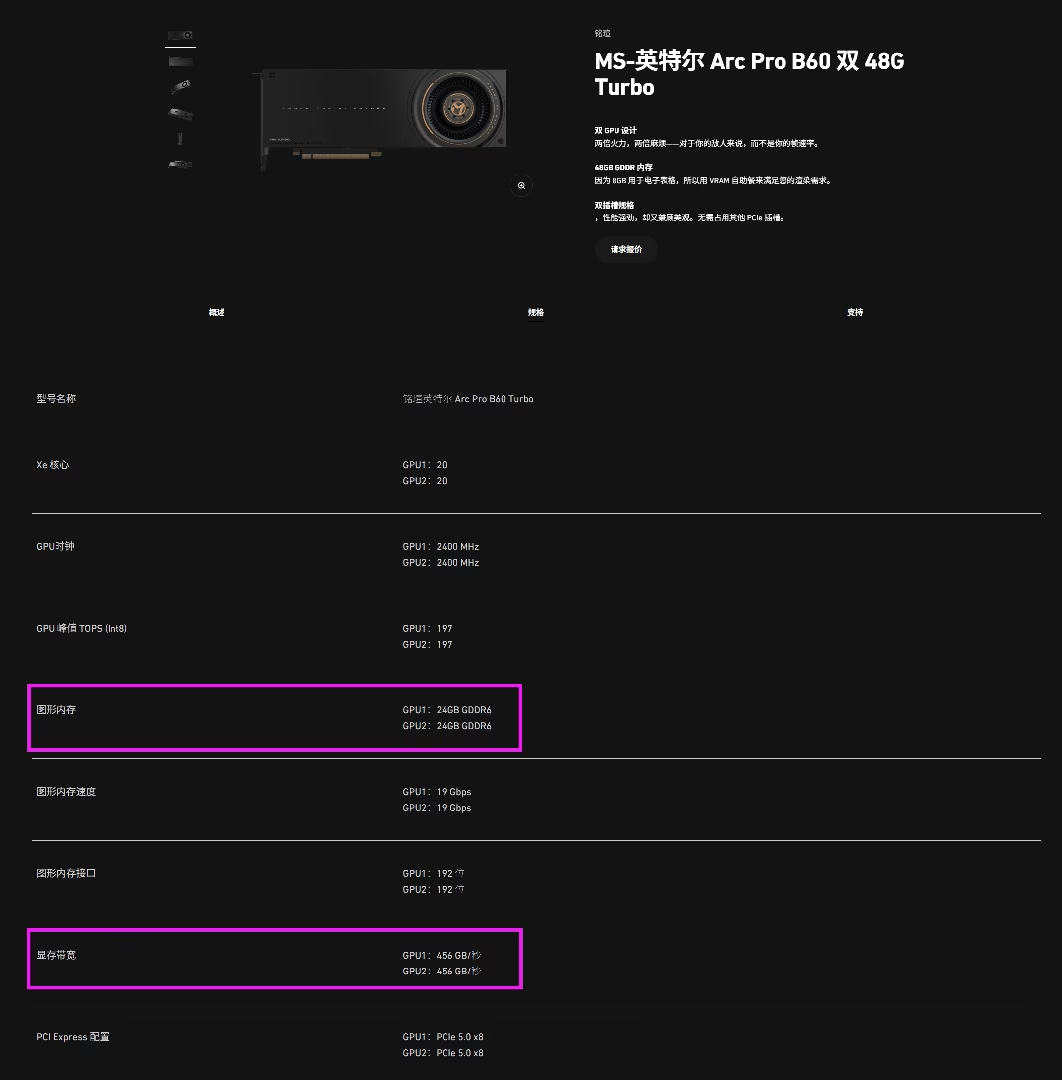

之前网传的 B60 二合一 48G 显存版本终于要来了。单个核心 24G GDDR6 带宽456GB/s 俩并行是 921GB/s 这个性能已经能跑 70B 4bit 规模的模型了(14 token/s 左右)。价格合适会是本地部署模型的有一个不错的选择。

来力,这几周太忙了 😇

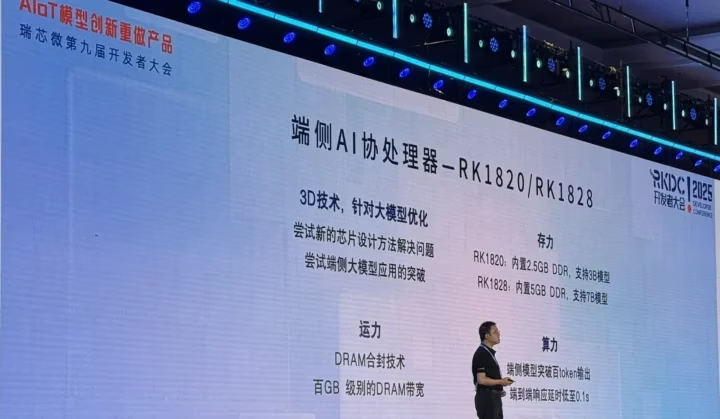

瑞芯微发了 RK3668,参数是 10 核 Arm Cortex-A730/Cortex-A530 ,外加 16 TOPS NPU,RK182X LLM/VLM 协处理器。

说实话从参数上看算力绝对够了,更多的是虽然配了 LPDDR5,甚至5X/6,但是内存带宽还是不太够,只有100GB/s. (NUP部分最高能支持 200GB/s LPDDR6) 建议至少拉到 400GB/s 这样绝对是跑本地小模型的神奇盒子。

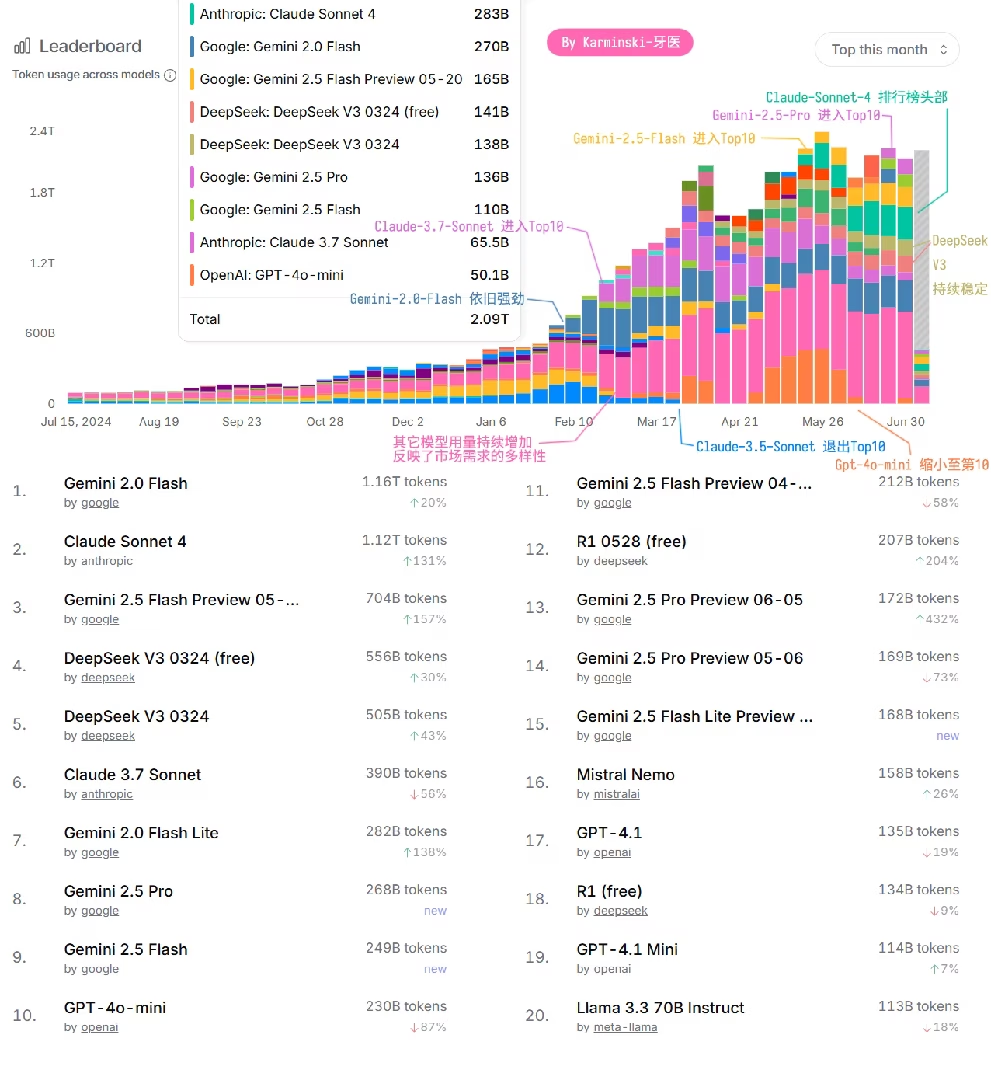

2025年已经过去了一半, 文本生成大模型是否已经进入下半场? OpenAI 完全不重视 API市场? Grok3根本没人用? 未来会怎样走向?

来看我花费4小时精心为大家整理的大模型 API 市场解读(使用 OpenRouter 数据) —— 2025上半年谁是 AI API 服务王者

竟然还有跑马灯。

重要的是价格老铁,只要足够便宜,就能日用哈哈哈哈👍

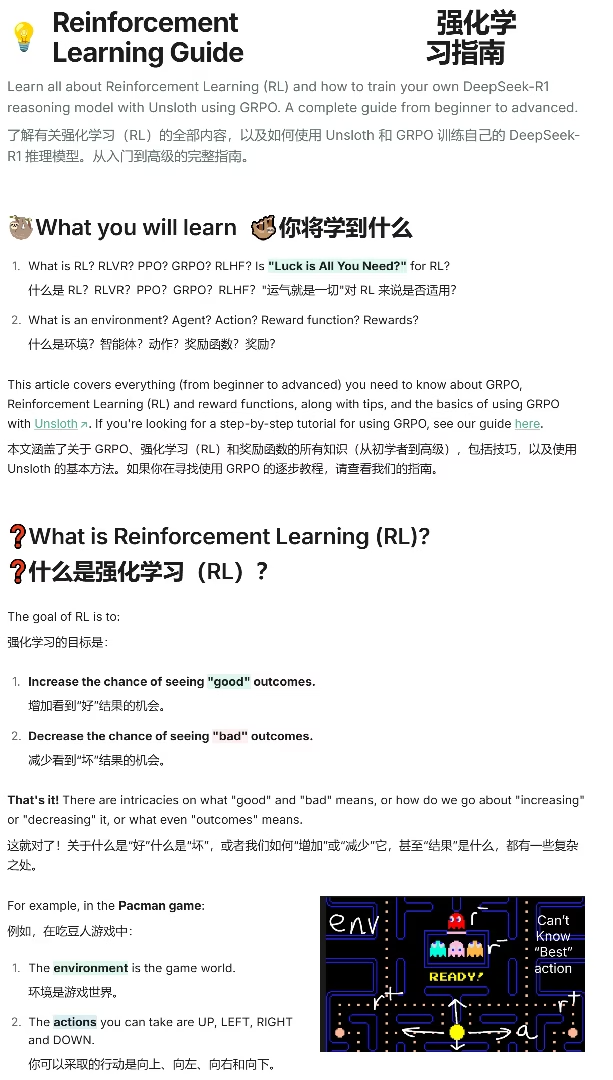

Unsloth 刚刚发布了一个强化学习小教程

教程从吃豆人游戏触发,然后简单介绍 RLHF, PPO 再到 GRPO, 然后告诉你如何用 GRPO 开始训练,是个不错的入门小文章。

地址: docs.unsloth.ai/basics/reinforcement-learning-guide

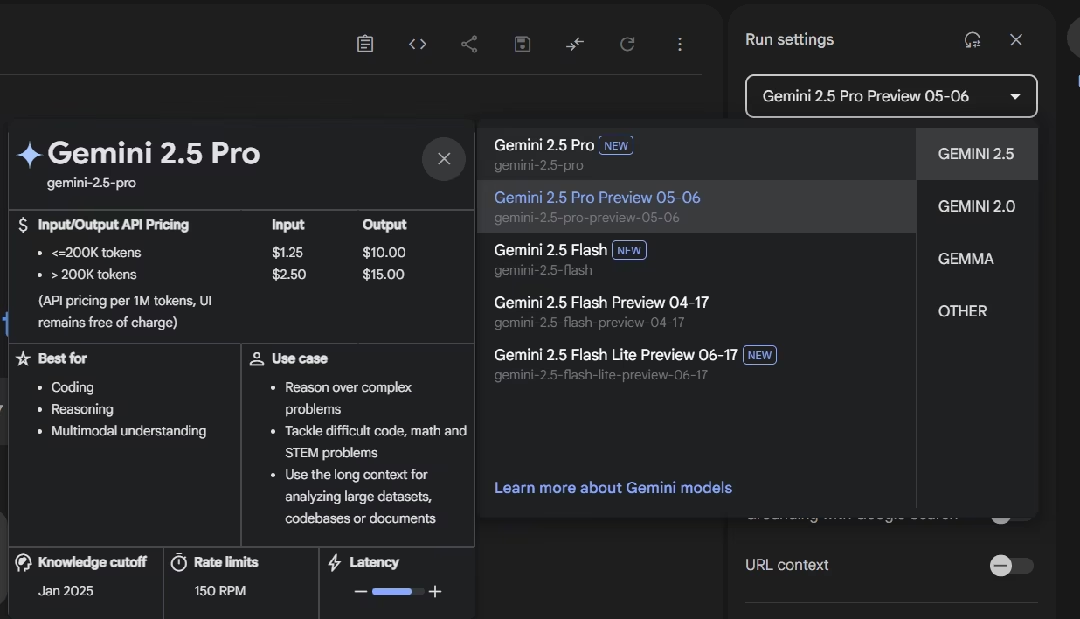

Gemini-2.5-Pro 和 Gemini-2.5-Flash 移除了 Preview 标签了。看来是版本固定了?加下来要向 Gemini Ultra 或者 Gemini-3迈进了

“磁碟”? 是台湾省的厂子产的吗?

昨天的 GCP 全球宕机事故报告出了,给大家解读下。

从 Google 的报告来看,是给全球的API管理系统下发了一个非法的配额策略(比如1小时只能请求1次这种离谱的策略),于是所有外部请求都403了(因为按照策略超请求配额了,于是403拒绝),工程师发现问题后立刻将所有接收到非法配额的API的配额系统全都绕过了,让这些API不检查配额策略直接给用户服务。

但是,但是来了,us-central1 地区的配额数据库过载了 (这里猜测工程师发现手抖应用错了策略,于是打算先恢复 us-central1 (在美国爱荷华州 Council Bluffs), 紧急情况下想都没想直接清除掉数据库中的旧策略,然后写入新策略,然后一看怎么还没生效,反而旧策略还在应用,检查后发现旧策略在缓存中,于是直接清空缓存!缓存失效,请求全部打在了数据库上,数据库就炸了…). 最终 us-central1 花费了更多时间才恢复。而其它区域则吃了us-central1的堑,使用逐步逐出缓存的方法,这也可能是为什么2小时才恢复的原因。

以上纯基于报告的猜测哈。感兴趣的同学还是请看原本的事故报告,写得是事无巨细: …

Intel 展位

首先还是最重磅的, Intel 把还没正式发布的 Arc Pro B60 拿过来了, 24G GDDR6, 456 GB/s, TDP 200 W. 从贴纸看这个还是工程样品. 我跟现场的工作人员说能否拔下来多拍几张, 结果被拒绝了, 因为没有螺丝刀. 机器搭配的是平平无奇 DDR5 4800.

面壁智能刚刚发了一堆小模型,包括: MiniCPM4-0.5B/8B/MCP/Survey 等等

- MiniCPM4-0.5B 是面向端侧设备的,8B是旗舰模型

- BitCPM4-0.5B/BitCPM4-1B 是类似 bitnet 的1bit 量化模型

- MiniCPM4-Survey 是个专门用于生成报告的模型

- MiniCPM4-MCP 是个MCP专用模型

另外还有一些视觉模型组件。目前从跑分上看,与 Qwen3-8B 不相上下,感兴趣的朋友可以试试。…

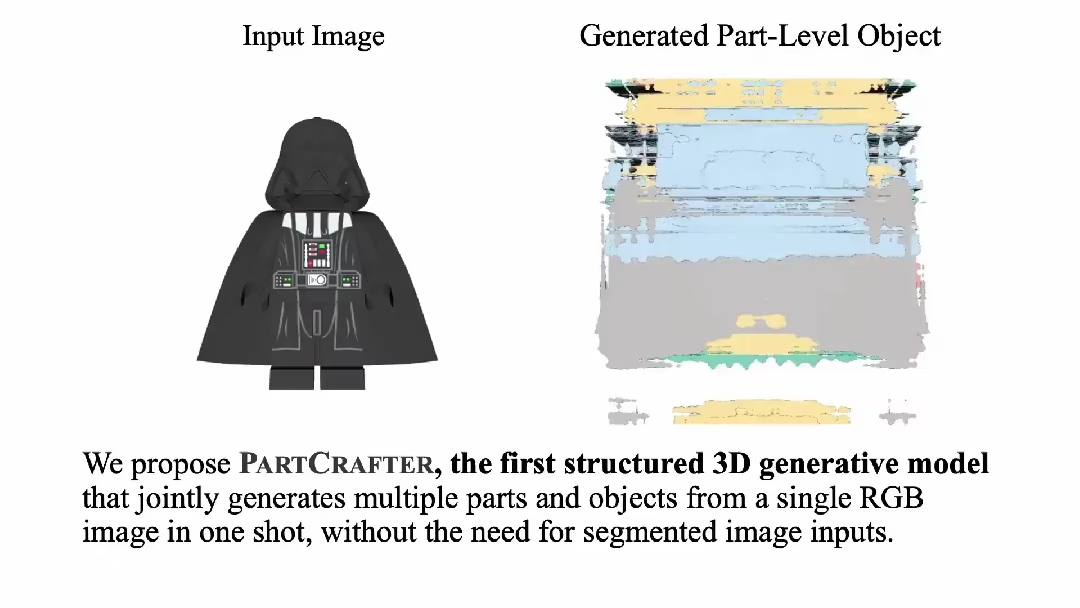

一张图搞定结构化3D建模——PartCrafter

这是一个来自北大+字节跳动+卡耐基梅隆大学的联合项目

简单来说,这个项目实现了从单张RGB图像直接生成多个语义部件的结构化3D模型,彻底告别了传统"先分割再重建"的繁琐流程,提供:

- 端到端生成:无需预分割输入,一步到位生成完整的部件化3D场景

- 组合式潜在空间:每个3D部件用独立的潜在token集合表示,支持灵活编辑…

草,自检几个小时怎么熬过去的,要我就以为纯纯的死机了

👍

搜沉浸式翻译,chrome插件

也是下血本了,导风罩竟然是钣金的

👍

👍👍👍

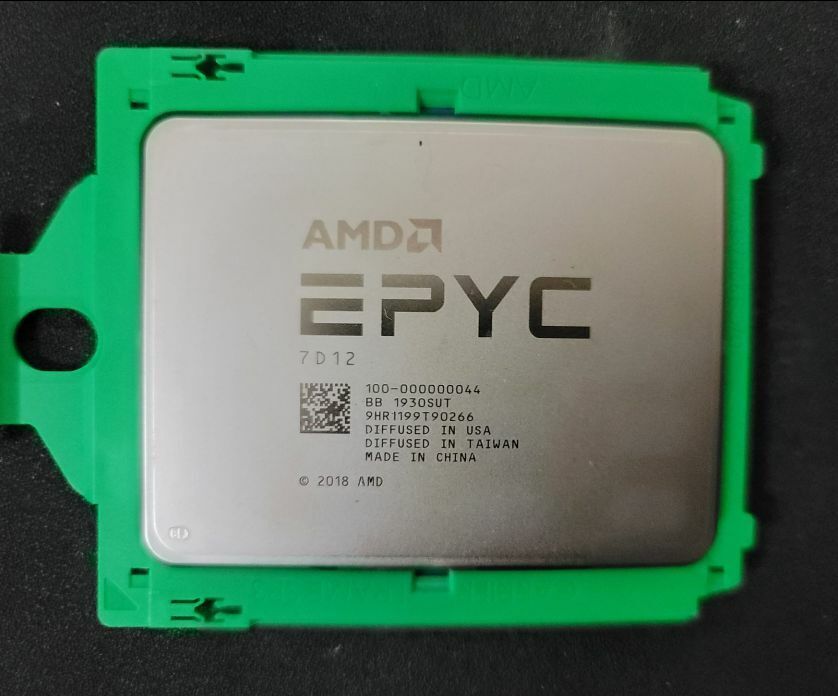

我一般是拿来组集群用的,并不嵌入哈哈

建议 PCI-SIG 给PCIe-8 增加热插拔。反正马上电信号就要扛不住了,不如直接不向前兼容,然后全部光口PAM4热插拔完事了(x

我比较好奇的是那个CX8,放在那么边角的位置,并且插头笼子也没散热,真的不会分分钟化掉么…

是的,感觉写作分数高就得靠传统媒体技能——瞎说…

请看llama.cpp的参数文档

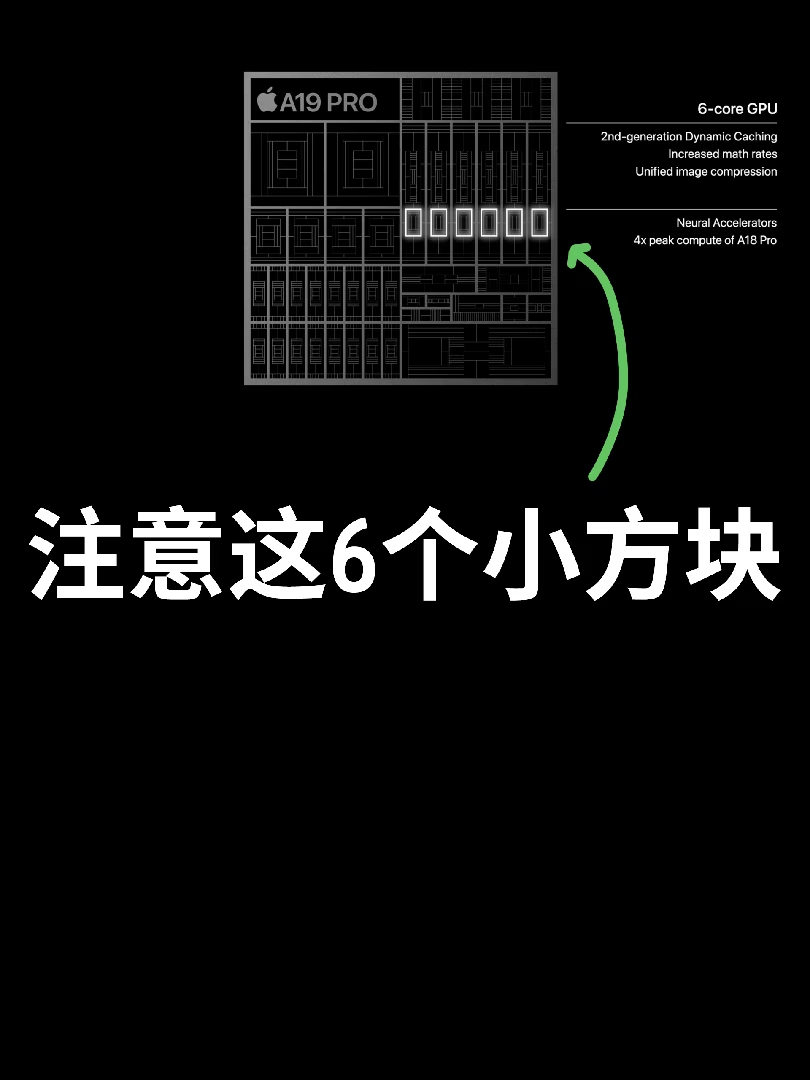

估计内存带宽还是最大273GB/s? 毕竟目前没看到除了果子家谁家LPDDR5X搞到800GB/s了

话说回来hunyuan这个web worker 代码要单独放一个,也是离谱,这些所有模型都没犯这么低级的问题。。。prompt明确要求了所有代码要放在同一个文件。感觉是训练材料太拉了。

我还是比较信 Aider Leaderboard 一些哈哈哈

可以试试,不过我还没来得及测

哈哈哈

Karma

- 369 Posts

- 415 Comments

Moderates

Homelab

- coming soon

好帖👍, 其实不训练光推理用x1的PCIe 4.0 足够了. 另外单槽卡是真的爽啊, 现在的垃圾游戏卡动不动要吃掉3槽绝了…