AI/LLM

sdxl和sd1.5生态上大部分漫画风格模型结构表现不如照片风格模型。但最近测试的wai illustrators v14在结构表现有一定优势,并且可用分辨率在2.5k以上,正式工作流使用1080p分辨率,比cosmos predict2快不少。

之前尝试使用SD1.5以及LCM版本的微调模型作为高速绘画模型,但分辨率、细节和位置关系等方面表现差一些。今天引入了基于SDXL Lightning的Dreamshaper XL,一定程度上解决了这些问题并且可以在部分场景实现动漫风格。

Unsloth 刚刚发布了一个强化学习小教程

教程从吃豆人游戏触发,然后简单介绍 RLHF, PPO 再到 GRPO, 然后告诉你如何用 GRPO 开始训练,是个不错的入门小文章。

地址: docs.unsloth.ai/basics/reinforcement-learning-guide

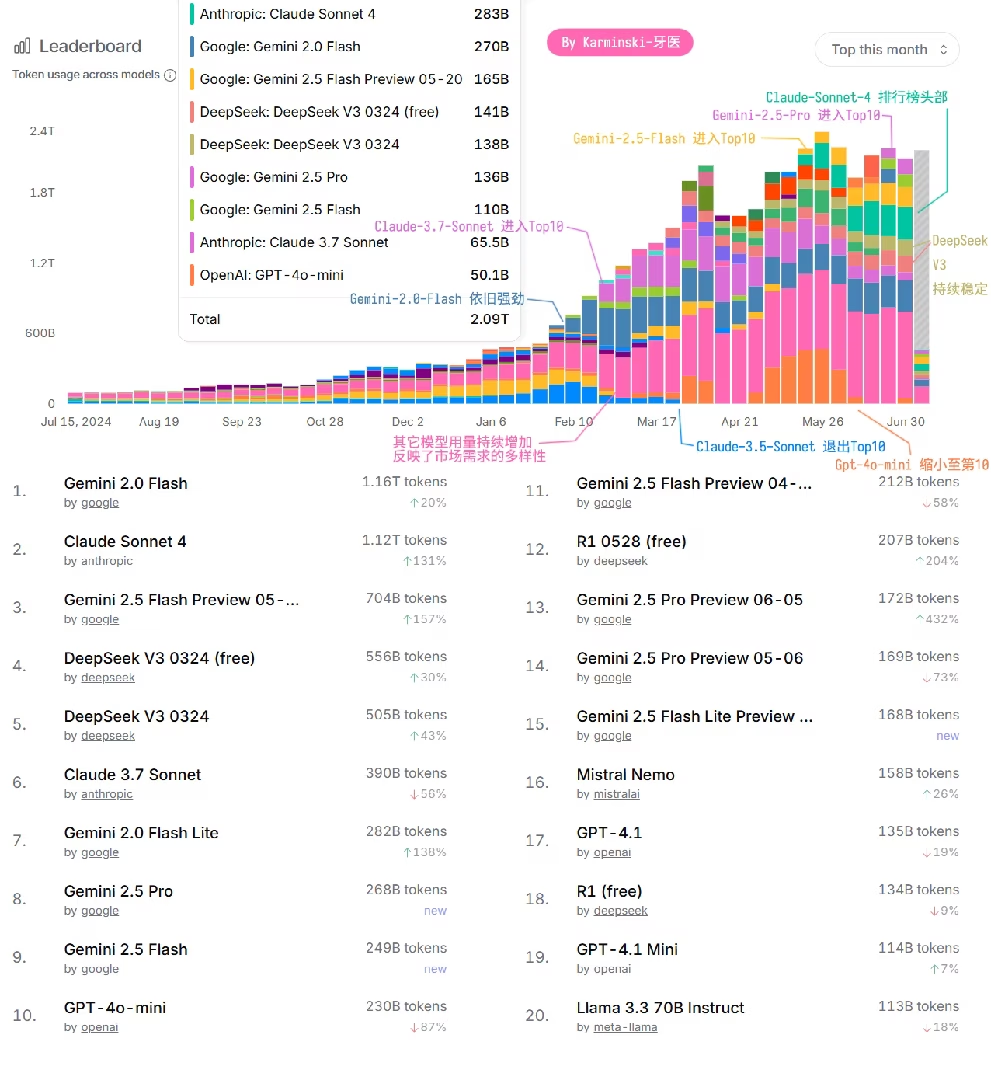

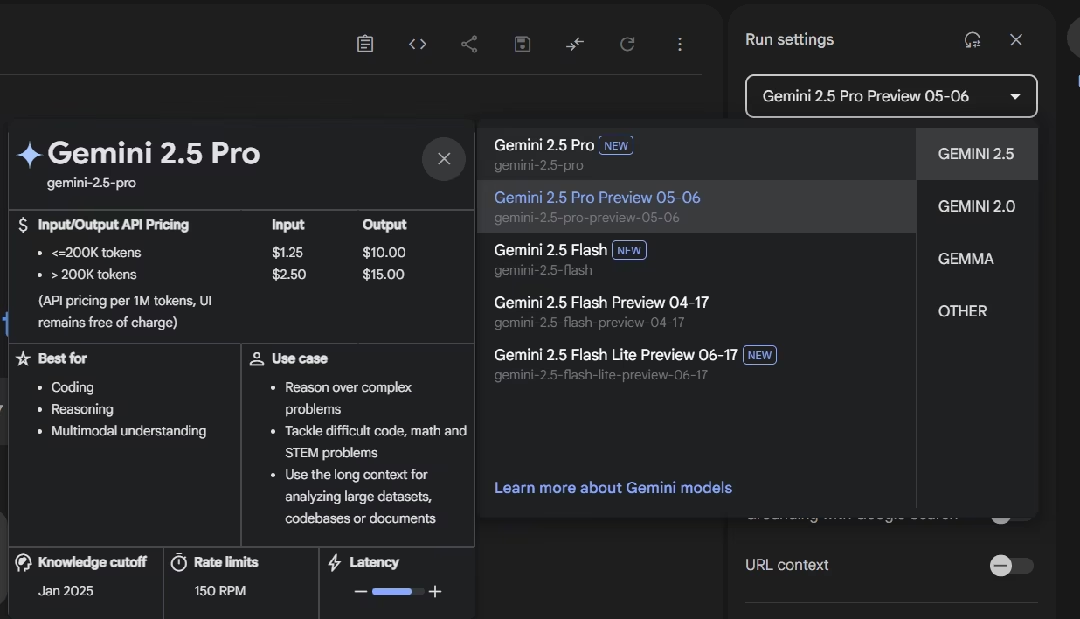

Gemini-2.5-Pro 和 Gemini-2.5-Flash 移除了 Preview 标签了。看来是版本固定了?加下来要向 Gemini Ultra 或者 Gemini-3迈进了

Intel 展位

首先还是最重磅的, Intel 把还没正式发布的 Arc Pro B60 拿过来了, 24G GDDR6, 456 GB/s, TDP 200 W. 从贴纸看这个还是工程样品. 我跟现场的工作人员说能否拔下来多拍几张, 结果被拒绝了, 因为没有螺丝刀. 机器搭配的是平平无奇 DDR5 4800.

面壁智能刚刚发了一堆小模型,包括: MiniCPM4-0.5B/8B/MCP/Survey 等等

- MiniCPM4-0.5B 是面向端侧设备的,8B是旗舰模型

- BitCPM4-0.5B/BitCPM4-1B 是类似 bitnet 的1bit 量化模型

- MiniCPM4-Survey 是个专门用于生成报告的模型

- MiniCPM4-MCP 是个MCP专用模型

另外还有一些视觉模型组件。目前从跑分上看,与 Qwen3-8B 不相上下,感兴趣的朋友可以试试。…

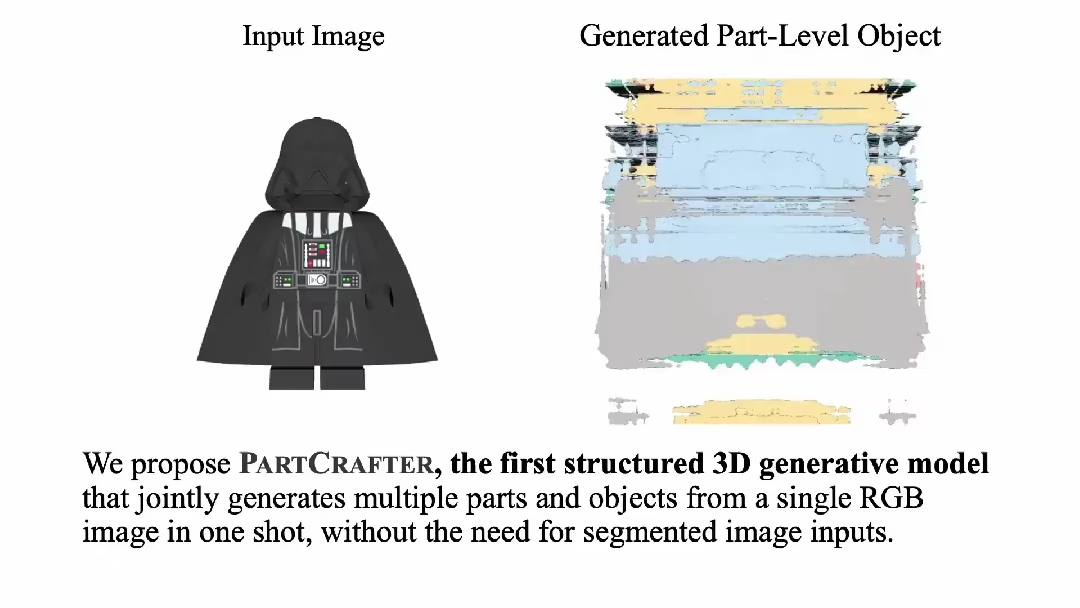

一张图搞定结构化3D建模——PartCrafter

这是一个来自北大+字节跳动+卡耐基梅隆大学的联合项目

简单来说,这个项目实现了从单张RGB图像直接生成多个语义部件的结构化3D模型,彻底告别了传统"先分割再重建"的繁琐流程,提供:

- 端到端生成:无需预分割输入,一步到位生成完整的部件化3D场景

- 组合式潜在空间:每个3D部件用独立的潜在token集合表示,支持灵活编辑…

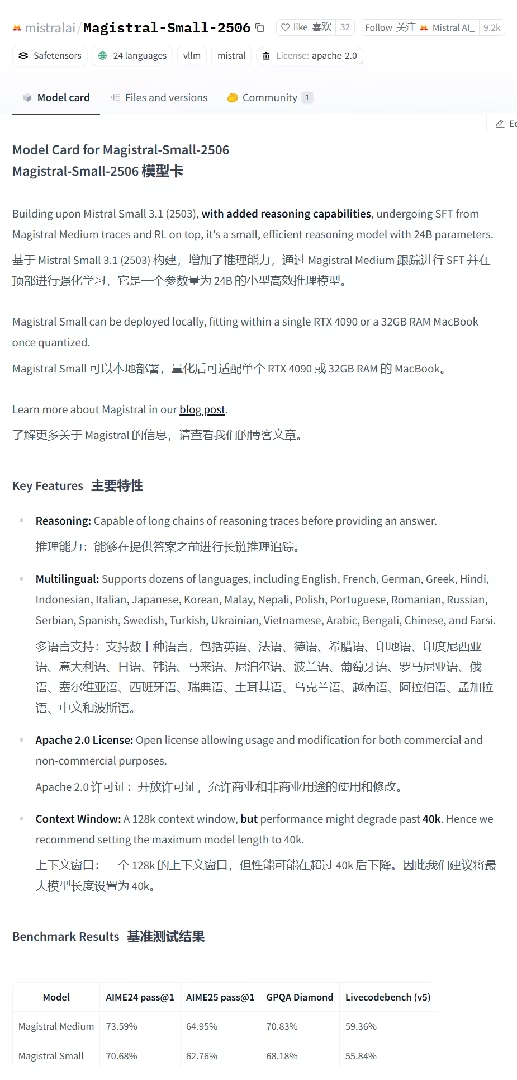

Mistral 刚又发了个小模型—— Magistral-Small-2506

这是个 Mistral Small 3.1 微调的版本,增加了推理能力的疯狂RL版本。这个大小很适合单卡 32G 跑。至于分数嘛… 跟 Qwen3-4B 差不多。GPQA 会高一些。但AIME甚至没有Qewn3-4B 高。

模型地址:huggingface.co/mistralai/Magistral-Small-2506 Unsloth 量化版本地址:huggingface.co/unsloth/Magistral-Small-2506-GGUF

考虑到提供了Enhance a Video等功能且支持模块化和量化后的VACE模型,虽然显存优化差一些但还是在Comfyui改用WanVideoWrapper而非官方工作流进行部署。

使用文生视频时,8g显存能生成33帧1152x640分辨率的视频,在3070m用时约26分钟。

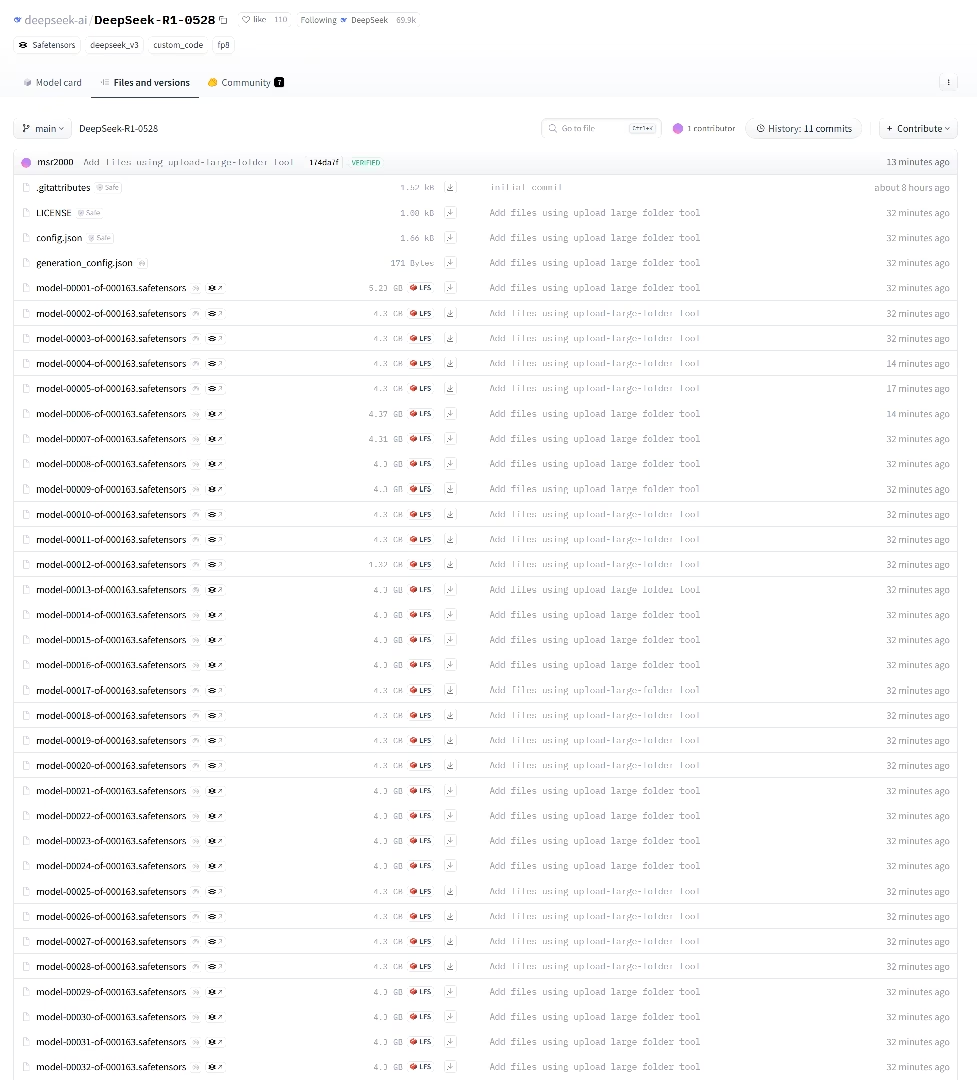

由于旧版Deepseek R1前端开发能力一般,而GitHub Pages以及这一页面需要展示的网页的开发对模型的前端开发要求较高,因此在Deepseek R1 0528发布后才开发这部分项目。

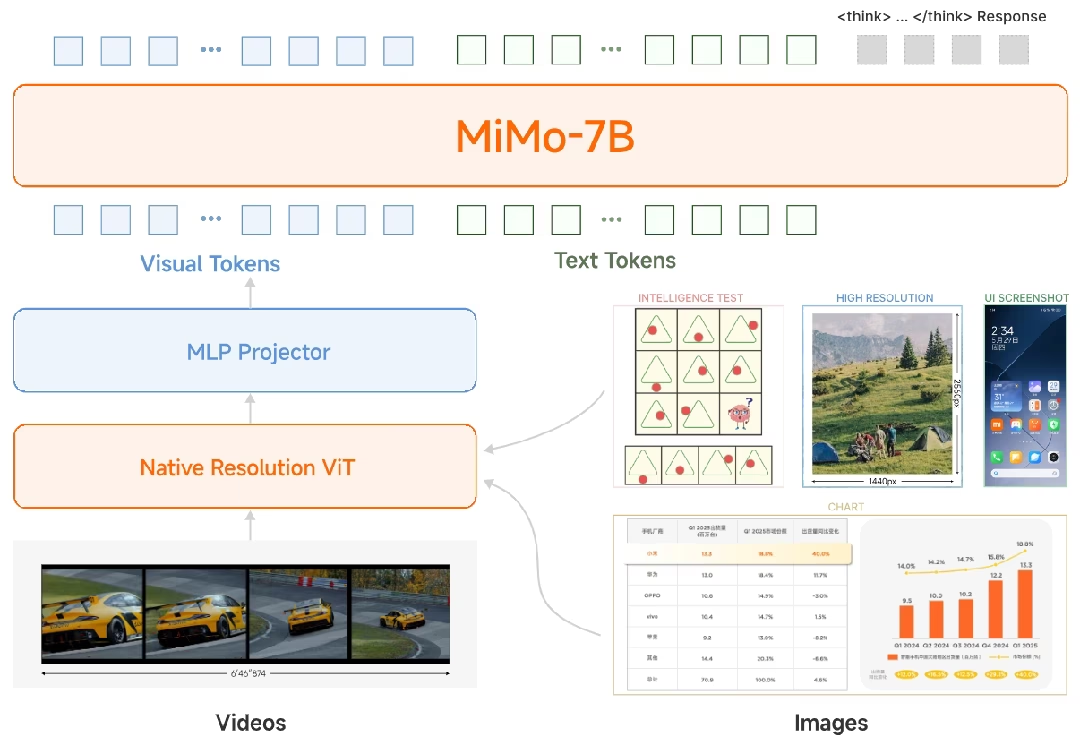

再来看小米发布的第二个新模型——MiMo-VL-7B-RL

这是个视觉模型,主打视觉推理,宣传也是在7B这个规模达到了领先,另外一个亮点是,它支持UI识别,因此可以当作各种界面操作MCP的前置模型。

由于官方没有放出在线使用地址,以及视觉测试我基本都没什么感知,所以感兴趣的朋友只能自己试试了。

地址:huggingface.co/XiaomiMiMo/MiMo-VL-7B-RL …

“昨天的我狙击了今天的你”

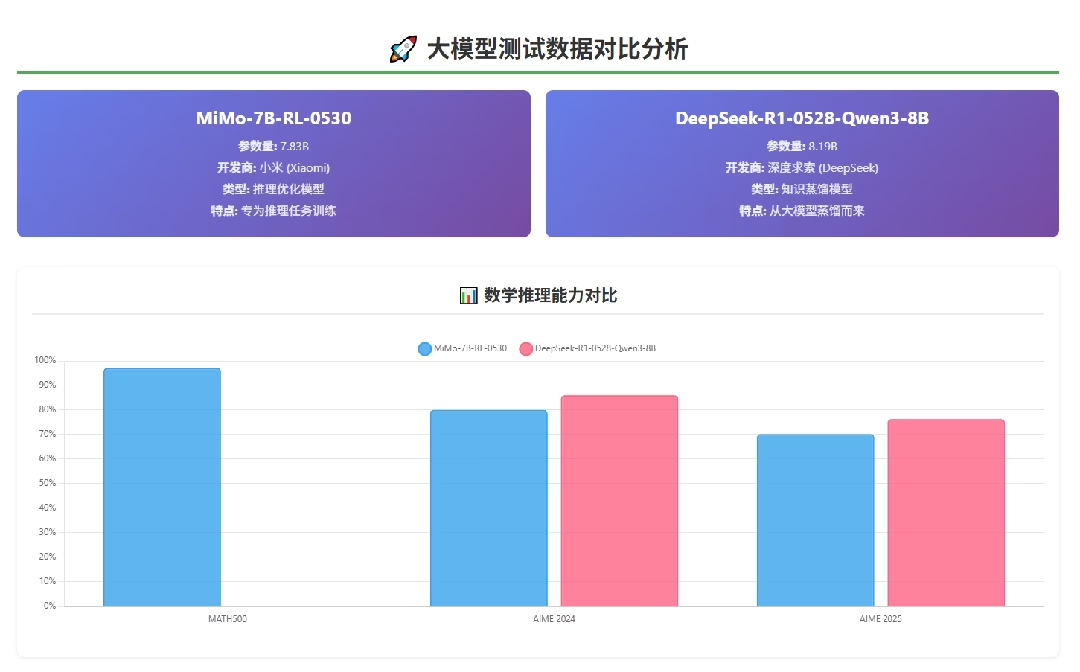

小米刚刚发布了两个新模型,我来给大家分别介绍,这个是第一个—— MiMo-7B-RL-0530

这是一个文本推理模型,跟 DeepSeek-R1 是一个类型。小米宣称这个新模型在 7B 规模这个是目前最强的模型。

官方比较的也是之前 DeepSeek-R1 蒸馏的 Qwen2.5-7B, 甚至说 AIME24 数学测试超过了旧版 R1,估计是也没料到 28 号 DeepSeek 发布了新蒸馏的 Qwen3-8B。 我把数据整理到一起给大家看。结论就是——没打过 DeepSeek-R1-0528-Distilled-Qwen3-8B. …

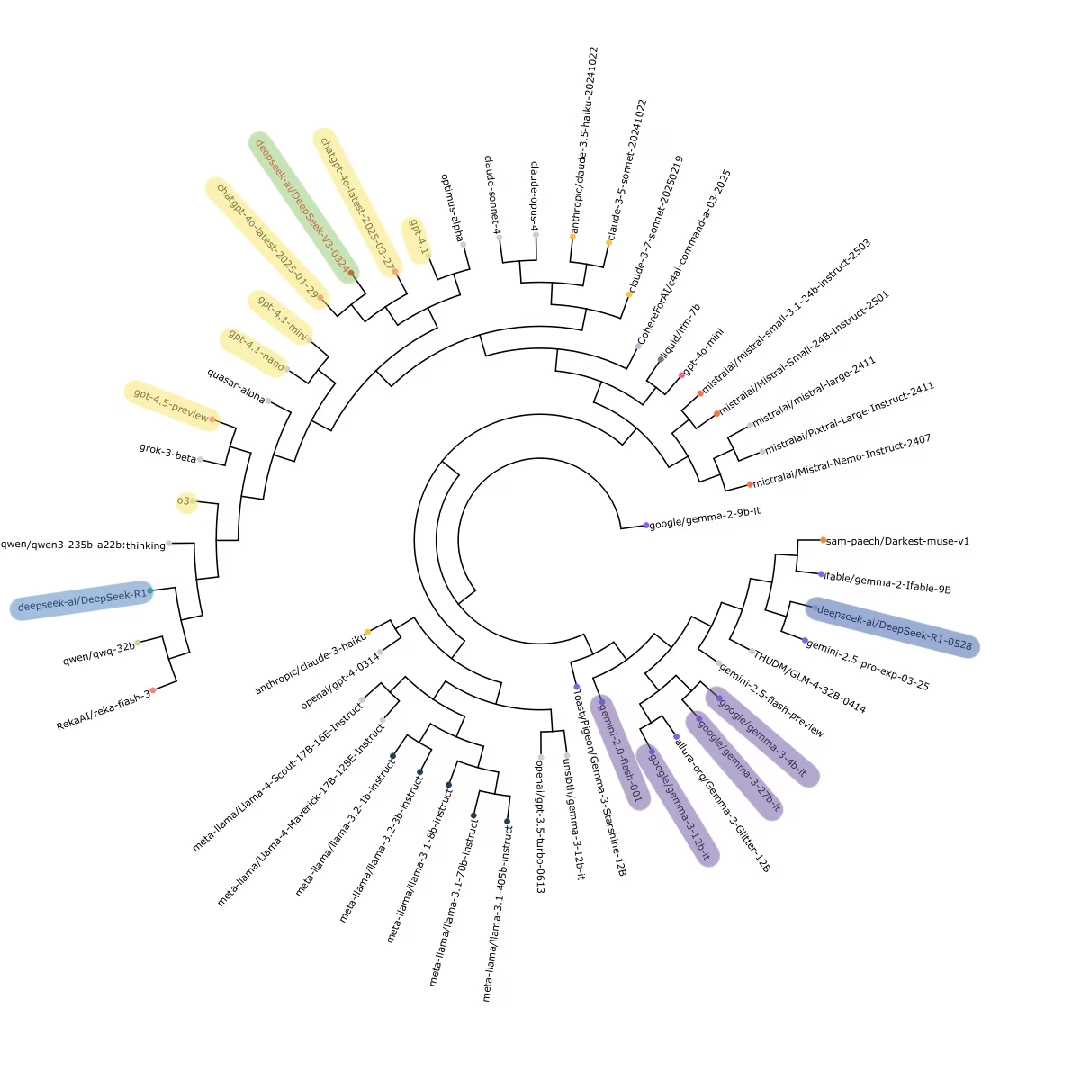

有数据显示 DeepSeek-R1-0528 的后训练数据可能是使用 Gemini 合成的, 之前的旧版R1则是用 OpenAI 模型合成的。图中是一个针对 DeepSeek 输出内容进行聚类的树,可以看到新版的 R1 在输出内容聚类上更靠近 Google Gemini, 而之前的 R1 则更靠近 OpenAI

AI能挖掘 0-day 漏洞了?

看到个安全研究员的博客, 使用 OpenAI o3 成功发现了个 linux 内核 0-day 漏洞. 当然发现过程并不是直接把内核4000万行代码扔进去. 而是有针对的分析.

blog 作者一直在审查 ksmbd (内核中的 samba3 协议服务器) 相关漏洞, 并且构建相关验证场景. AI 最大的用处是帮助人分析代码, 相关的代码片段大概 3300 行, o3 目前上下文召回也是最强的, 所以很适合这个场景, 然后 o3 就发现了个变量释放的引用计数器bug, 导致其它线程可以访问.

由于前段时间使用的Hidream i1 full等模型速度较慢,近期希望查找速度更快的模型用于非正式作品,总体要求是绘画模型在3070m上生成时间10秒内,视频模型单帧生成时间4秒内。

绘画模型用LCM比较快,但有LCM的模型较少,考虑速度因素,选择了以SD1.5为底模的Cyberrealistic v32,在人物等用途的总体效果也优于不少专用模型,只有航拍效果略低于ArchitectureRealMix。30步生成1024x680分辨率的图片在3070m上用时8.2秒。至于其它底模,SANA Sprint速度还要快不少但生成效果较差。

视频模型考虑速度和效果,选择了AnimateLCM SVD xt,是SVD xt的LCM版本,虽然后段画质有一定下降但总体上能用,8步生成1024x680分辨率的视频在3070m上单帧用时3.8秒。至于其它模型,AnimateDiff Lightning和LTX Video 0.9.6速度更快,但前者细节表现较差,后者只适用于部分题材。

以下是几组生成案例: …