其实前几天就完成更换了,但忘记在这边发。

昨天看到有人提到名称泄露,基本确认kingfall是gemini2.5 ultra。不过个人感觉再出更大参数量的版本意义不大,o3降价后与gemini2.5 pro相当,但仍然比deepseek r1贵几倍。达到这一级别后专注于同参数量下模型迭代,有助于控制成本。

之前在一些讨论看到有人提到名称为kingfall的模型,性能优于gemini2.5系列,可能是gemini3的早期版本。

关闭量化后画质还是有一些问题,后面引入了Accvid,之前Hunyuan Video的Accvid是5步,Fast Video是6到8步,都有一定画质问题。Wan2.1的Accvid改为10步,画质损失比较小。由于速度提高,顺便检查了一下Teacache,发现之前Teacache默认是按图生视频版本的比例的,调整后画质正常了。

后面的视频是关闭量化的。40系开fp8 fastmode的话应该有一定速度提升,但据说画质也差不少。

前两天用起来感觉画质还是差一些,今天发现是模型加载节点选了量化,该节点量化选项对显存占用和速度没影响,但会降低画质。不过文本编码器加载节点还是要开量化以降低显存占用。

考虑到提供了Enhance a Video等功能且支持模块化和量化后的VACE模型,虽然显存优化差一些但还是在Comfyui改用WanVideoWrapper而非官方工作流进行部署。

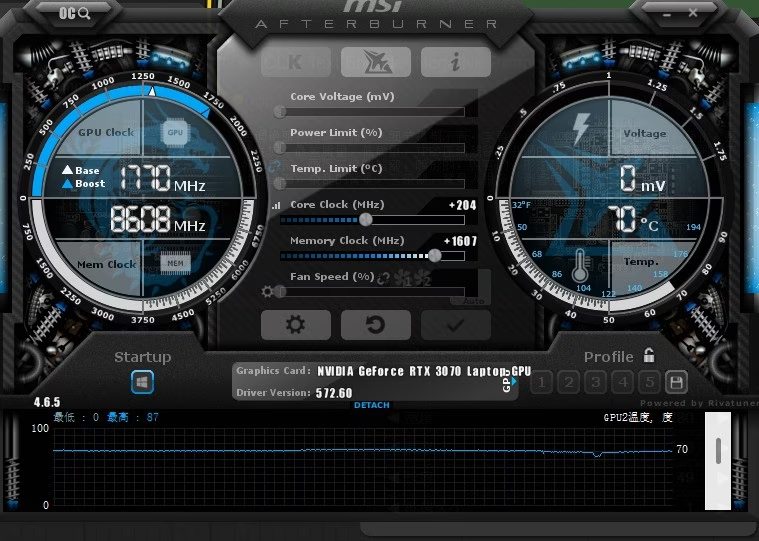

使用文生视频时,8g显存能生成33帧1152x640分辨率的视频,在3070m用时约26分钟。

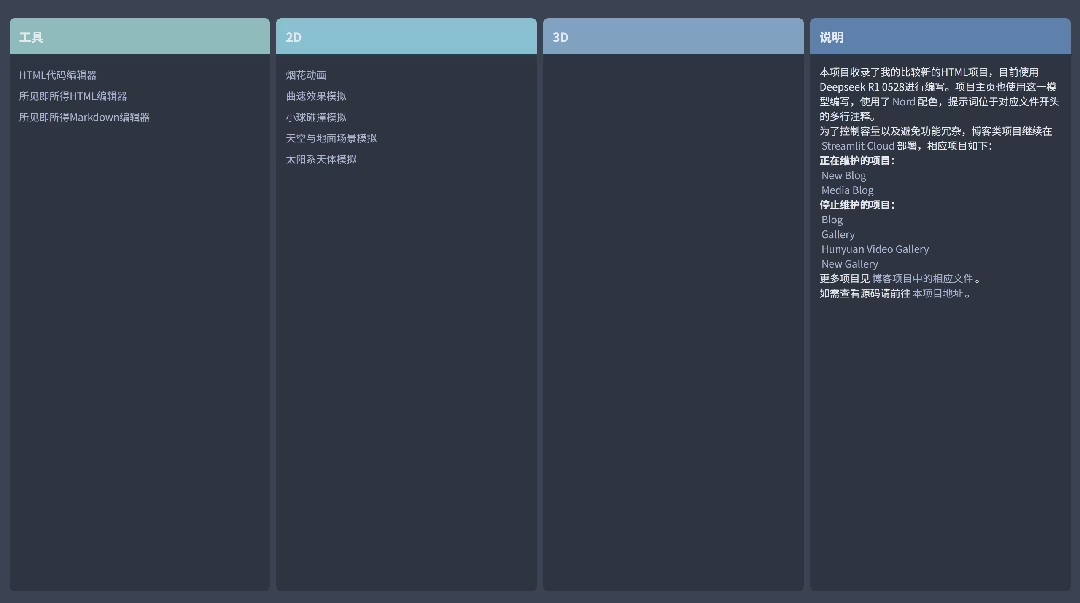

现在一共做了15个项目,重新总结一下Deepseek R1 0528在web开发的特点:

- 一个重要提升是编辑能力有较大改善,使用编程插件时可以进行多轮更改,可用的程序规模大幅增加。

- 控件和界面编程水平有较大改善,逻辑功能有一定缺陷。

- 2D内容和程序化生成等方面有较大改善,也降低了对p5js等较易用的库的依赖。虽然不能完全满足需求但考虑修改的情况下可以完成大部分项目。

- 3D内容的表现仍有较大局限性,不少应用场景相比旧版提升不大,有的项目甚至要用旧版生成的程序作为参考。

昨天主要用官方api开发,主要考虑测试目前api用量是否明显受限,用了7.78元,没有遇到限速问题。今天主要调用openrouter上的免费api,用3个号能覆盖大部分需求。

由于旧版Deepseek R1前端开发能力一般,而GitHub Pages以及这一页面需要展示的网页的开发对模型的前端开发要求较高,因此在Deepseek R1 0528发布后才开发这部分项目。

由于前段时间使用的Hidream i1 full等模型速度较慢,近期希望查找速度更快的模型用于非正式作品,总体要求是绘画模型在3070m上生成时间10秒内,视频模型单帧生成时间4秒内。

绘画模型用LCM比较快,但有LCM的模型较少,考虑速度因素,选择了以SD1.5为底模的Cyberrealistic v32,在人物等用途的总体效果也优于不少专用模型,只有航拍效果略低于ArchitectureRealMix。30步生成1024x680分辨率的图片在3070m上用时8.2秒。至于其它底模,SANA Sprint速度还要快不少但生成效果较差。

视频模型考虑速度和效果,选择了AnimateLCM SVD xt,是SVD xt的LCM版本,虽然后段画质有一定下降但总体上能用,8步生成1024x680分辨率的视频在3070m上单帧用时3.8秒。至于其它模型,AnimateDiff Lightning和LTX Video 0.9.6速度更快,但前者细节表现较差,后者只适用于部分题材。

以下是几组生成案例: …

后面的结论不太对。非并发下算力利用率通常是比较低的,有人测试过vllm开到32并发对生成时间影响不大。如果是原本没有并发需求的本地部署场景还是比较有优势的,但用api相当于要相应倍数的价格就不如自己用更大的模型。这算是下一代推理模型的一个方向,但比较主流的貌似还是集束搜索。o3/o4mini还是采用了总结思维链的形式,要等deepseek r2出来才能知道具体的技术路线。

层数多可以把引脚做得更密集,主要用于高集成度设备。不过这个层数的确少见。

今天测试了一下,音频输入用长音频可能有问题。以后如果添加滑动窗口,还是有望在实现实时交互的同时代替常规的ASR/TTS模型。音频输出的问题问过了,实际上还没有添加回放功能。

HiDream i1 full在3070m上生成1920x1088分辨率的图片要12分钟,dev版本要3.5分钟,fast版本要2分钟,因结构表现下降不推荐使用。目前TeaCache还没有支持。

生成效果方面,HiDream i1 dev效果优于Flux.1 dev,但细节和光照表现还是明显低于HiDream i1 full,后者生成效果也接近比较优秀的闭源绘画模型。考虑后续有TeaCache支持的速度情况,个人还是偏向full版本。

HiDream i1发布有一段时间了,在这个适合测试是因为刚开始看到光照不如Pixelwave FLux.1 dev,但使用后者遇到细节问题,就决定尝试HiDream i1。个人认为综合光照表现,HiDream i1仍然是更好的选择。

最近使用AI辅助创建了两个项目,仍然使用Streamlit,功能比以前的项目复杂,算是实现了个人比较满意个人网站功能: https://github.com/Willian7004/new-blog https://github.com/Willian7004/media-blog 。

仓库内大部分程序是使用Deepseek R1编写的,在文件开头的多行注释记录了提示词。有几个程序试过用Qwen3 235b,但大部分程序还是Deepseek R1表现更好。不过虽然是比较简单的技术栈,部分程序也接近Deepseek R1的能力上限了,需要多次生成或人工修改才能完成。另外规划了一个GitHub Action,用于在每次更新时分别创建更新文件列表和更新文件全文的release,但没有实现预期功能,最终弃用了。

这两个项目改用markdown存储文本,后续也方便与GitHub Pages对接,但至少要等Deepseek R2推出才有希望正式转到web技术栈。

新特性有一定优势,但性能上限相比deepseek r1的提升比较小,与o4 mini还有较大差距。主要优势是30b版本上混合推理或预测解码,在主流配置能部署性能相当于deepseek r1的模型。

感觉还是比较依赖cpu性能,并且30b版本显存足够,纯gpu推理应该更快 🤣 。主要还是希望能在主流配置上(8到12g显存,6到8核cpu带avx2)对30b版本有比较好的推理效果,这样就能做到接近32b版本的效果。

可能是刷分了或者没有对这类任务优化,还是要等更多实测才能确定。

可以一步到位上魔改u(doge)。用桌面u的话看具体的预算节省幅度再决定。

楼主最近开始关注卡片电脑了吗?我最近也了解了一些。树莓派虽然“生态”较好,但做嵌入式linux有内核和驱动开发需求且注重成本控制,通常都用瑞芯微和全志等品牌的。加扩展板用于AI应用的话算力和生态比不上价格接近的香橙派aipro的20tops版本以及英伟达jetson。

有人分析过这类设计,只是处理器数量较多,算力密度没有优势。

长上下文通常用于输入较长的参考资料,用于翻译的话输出长度不够。长上下文,成本更低以及同时在文本和多模态任务有较好表现都是优势。后者此前基本只有闭源模型达到。

两个模型架构不同。demo上的是Lumina-Image-2.0。

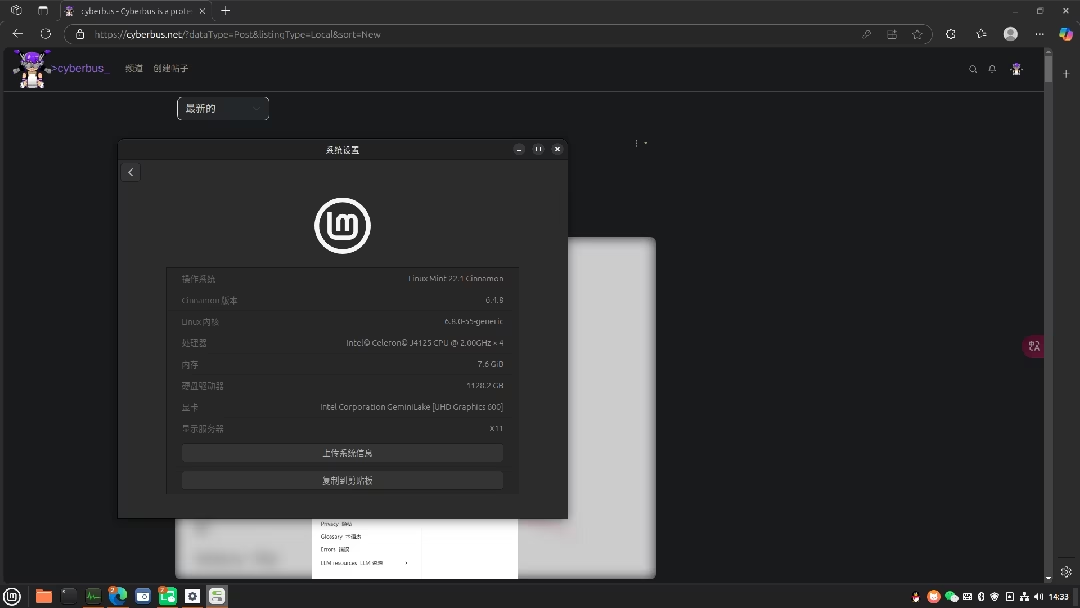

我的主力机是笔记本电脑,接触垃圾佬领域和Linux后为了尝试在低配设备运行Linux且考虑到宿舍的空间问题,设备选择上偏向瘦客户机或迷你主机。先后入手了j1800版本的升腾c92和一台使用j4125的迷你主机。

实测发现j1800适合轻量化桌面环境,网页性能较差,而j4125可以满足主流桌面环境和网页的性能需求,又考虑到缩略图生成速度的问题,经过几轮调整最终在j1800主机安装有较好的Xfce桌面外观的kail linux并作为客户机(使用xrdp),j4125主机安装linux mint作为局域网服务器提供远程桌面、文件服务器(sftp)、媒体服务器(docker版jellyfin)和其它网页服务(也使用docker)

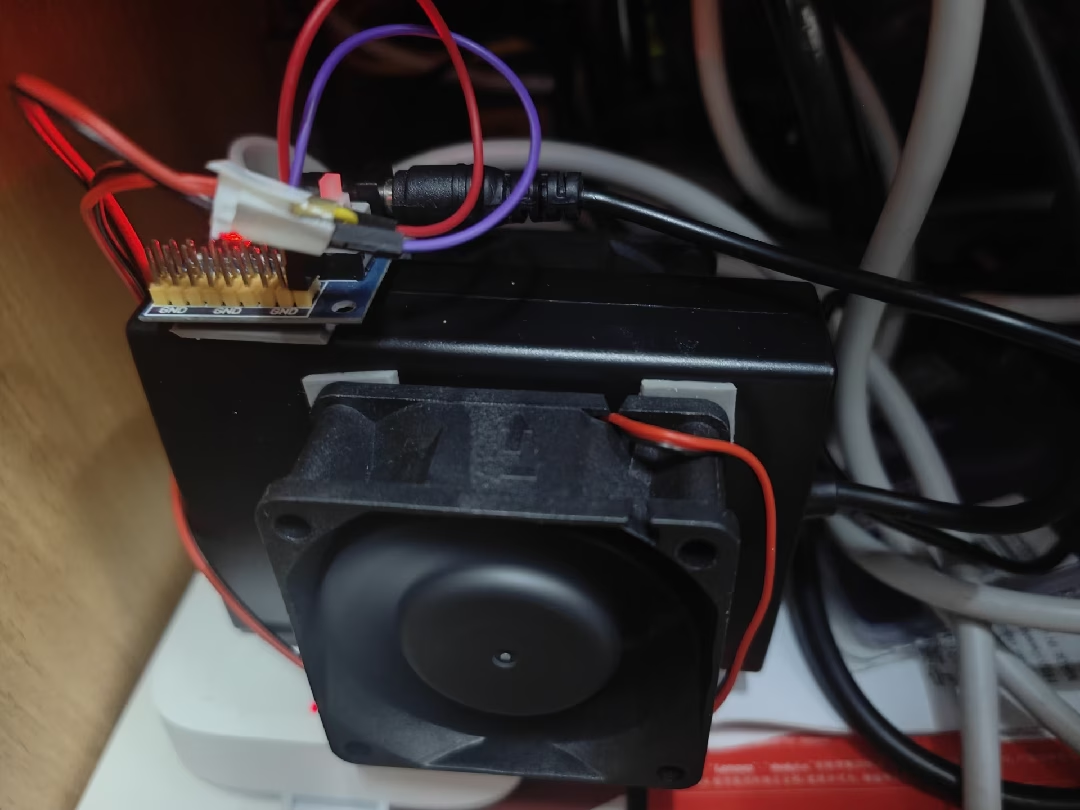

由于我的笔记本电脑原装电源最近不太稳定,前段时间入了一个氮化镓电源,体积有优势但散热差。就入了两个风扇,用强力双面胶固定,供电使用usb升压线,由于风扇最大功率下噪声较大就改为两个串联了,电源也能跑满额定功率。