Qwen 又发新模型了! ParScale-1.8B-P1 (P2,P4,P8)

这个 P 是什么意思?没错,就是这个模型最新颖的点。大家知道提升模型能力要么增加参数量,要么疯狂推理(类似QwQ一个问题要想3分钟)。于是 Qwen 团队又搞出了一个新方法,干脆并行推理。于是他们发明了新的方法——ParScale

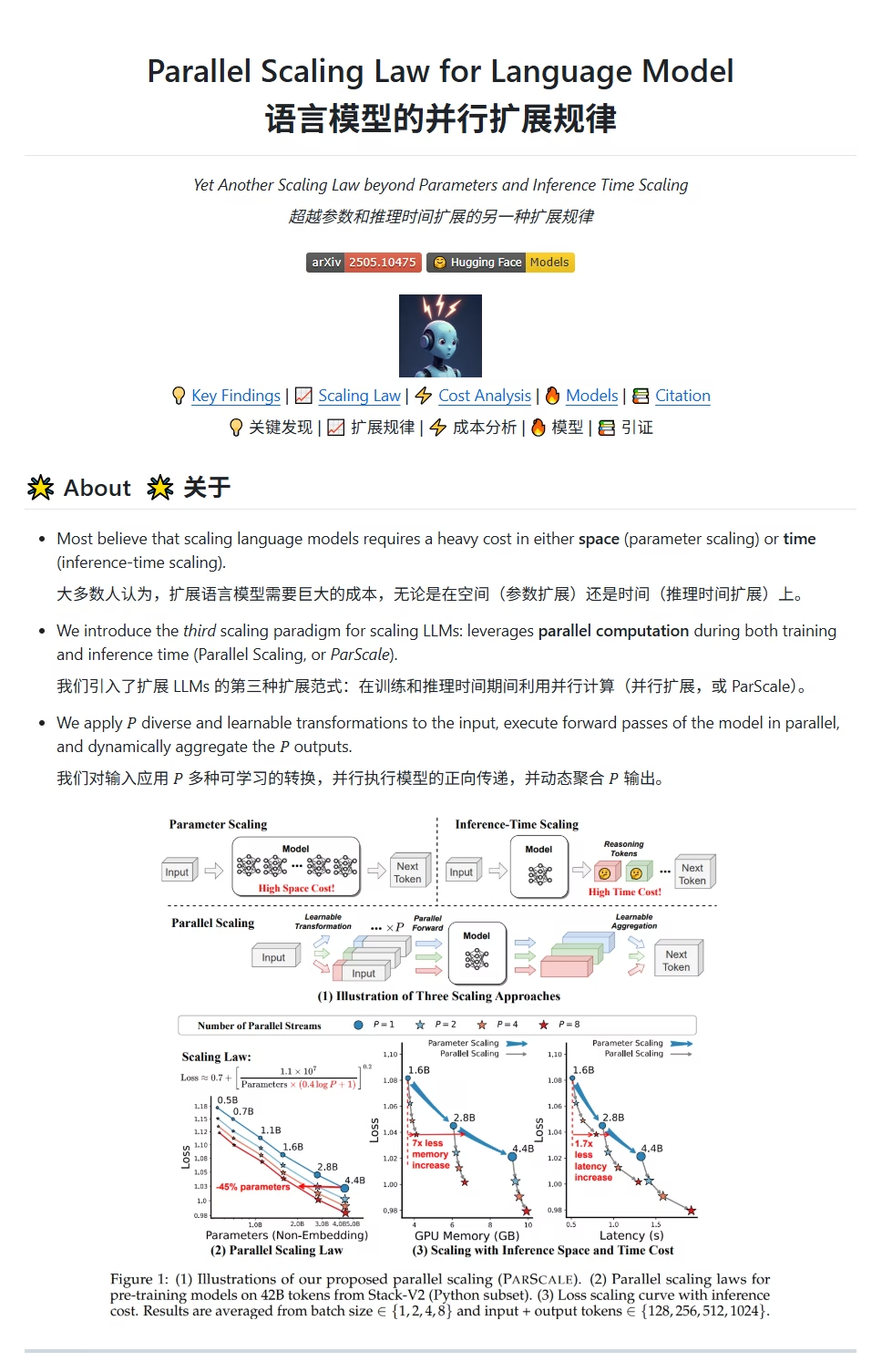

简单讲 ParScale,首先使用 n 个并行流进行推理 (就是模型后缀的Pn),但这些不是相同的推理启动多个,而是使用可学习的差异化变换(transformations),这些输入的内容在模型中前向传递(使学习变换后的内容具有关联性)。最后使用动态聚合机制合并所有输出结果。

Qwen 团队验证,使用这个方法能近似相当于给模型扩展参数,使用P个并行流的扩展相当于将参数数量增加 O(log P) 倍。比如 30B 的模型,如果 8 个并行,那么效果相当于一个 42.5B 的模型。

当然也可由反着用,给现有模型增加并行度,这样就可以进一步缩小模型。

我感觉如果这个方法真的可用,那么对显存开销是进一步的利好,如果想要达到 DeepSeek 685B 的性能,只需要一个 484B-P8 的模型即可。当然,并行带来的代价肯定是显卡算力需求的提升,以及显存带宽仍然是最大瓶颈。因此不会提升推理速度。甚至可能还会因为合并阶段的存在,推理速度会下降一些 (游戏卡的情况,用 H100 的老板当我没说)。

论文地址:github.com/QwenLM/ParScale 模型地址:huggingface.co/ParScale/ParScale-1.8B-P1

后面的结论不太对。非并发下算力利用率通常是比较低的,有人测试过vllm开到32并发对生成时间影响不大。如果是原本没有并发需求的本地部署场景还是比较有优势的,但用api相当于要相应倍数的价格就不如自己用更大的模型。这算是下一代推理模型的一个方向,但比较主流的貌似还是集束搜索。o3/o4mini还是采用了总结思维链的形式,要等deepseek r2出来才能知道具体的技术路线。

求一下牙医看网页用的什么翻译插件,看起来很好用的样子。

搜沉浸式翻译,chrome插件

沉浸式翻译 感谢~