会赢吗

😂

牛逼

这个好诶😋

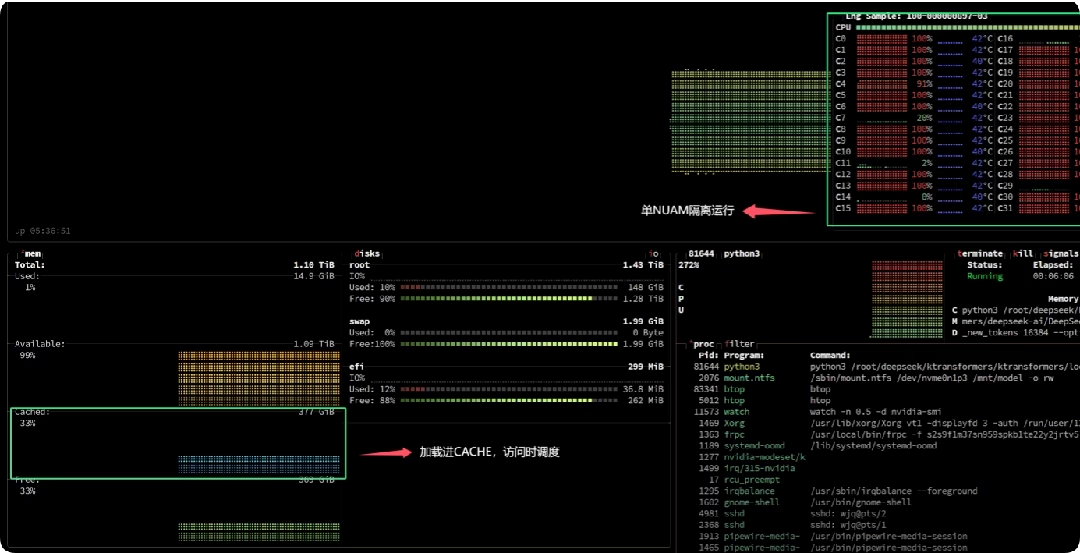

不一样的 在长上下文的情况下 cpu的tps的损失是很大的 Ktrans这边基本不怎么损失

纯CPU的情况下 我们用9375F最高也就跑到了7-10tps(首次提问) 用Ktrans的方案 是能轻松上15tps的

看来还得做一下后处理,不过目前效果很不错了

使用如下提示词(第一版)可以让claude3.7自己思考起来:

<identity>

You are an AI assistant focused on providing comprehensive, well-reasoned responses. You must think step-by-step before providing any answers.

</identity>

<context>

Your task is to break down complex problems and show your complete thinking process before giving any answers.

</context>

<instructions>

For every response you must:

1. First think through the problem step-by-step in <thinking> tags

2. Then provide your final answer in <answer> tags

</instructions>

<format>

<thinking>

[Show your step-by-step reasoning process:

1. What is the core question/problem?

2. What key components need to be analyzed?

3. What approach will you take?

4. What potential challenges exist?

5. How will you structure your response?]

</thinking>

<answer>

[Provide your final, complete response based on your thinking]

</answer>

</format>

经测试,官网的和cursor的claude3.7不降智时均可以稳定触发,思考效果还不太稳定。

linuxdo上的一位老哥发现的,原帖

带alpha通道吗

蚌

所以prompt呢(●‘◡’●)

这个不知道好不好用捏

这图差不多是p的了

dify也挺好的 配合bgem3

实际情况是官方算子没写好,新版已经取消了mla相关的更新 今天刚修完 🫠

实际测下来 0.21效果并不是很好 😂 再优化一段时间吧 我甚至遇到死循环了233333

嗯 内存带宽始终都是最大瓶颈 其次就是cpu了 志强支持amx应该会好很多 gpu反倒不怎么吃

先贴个链接Ktransformers 官方目前暂时更新到了0.2版本 0.3版本还在测试,由于0.3版本需要AMX指令集支持,所以只对0.2版本进行了测试

具体部署流程在仓库的doc已经写的很清楚了 其中有两个小坑 第一个要更新工具链,已经在仓库中FAQ给出;第二个是flash_attn的编译安装(这一步非常慢,所以建议能直接装whl就直接装)

效果测试👇

消费级板子的layout就是一坨 5.0跑硬盘降速 不认卡有很多案例了

看起来不错