先贴个链接Ktransformers 官方目前暂时更新到了0.2版本 0.3版本还在测试,由于0.3版本需要AMX指令集支持,所以只对0.2版本进行了测试

具体部署流程在仓库的doc已经写的很清楚了 其中有两个小坑 第一个要更新工具链,已经在仓库中FAQ给出;第二个是flash_attn的编译安装(这一步非常慢,所以建议能直接装whl就直接装)

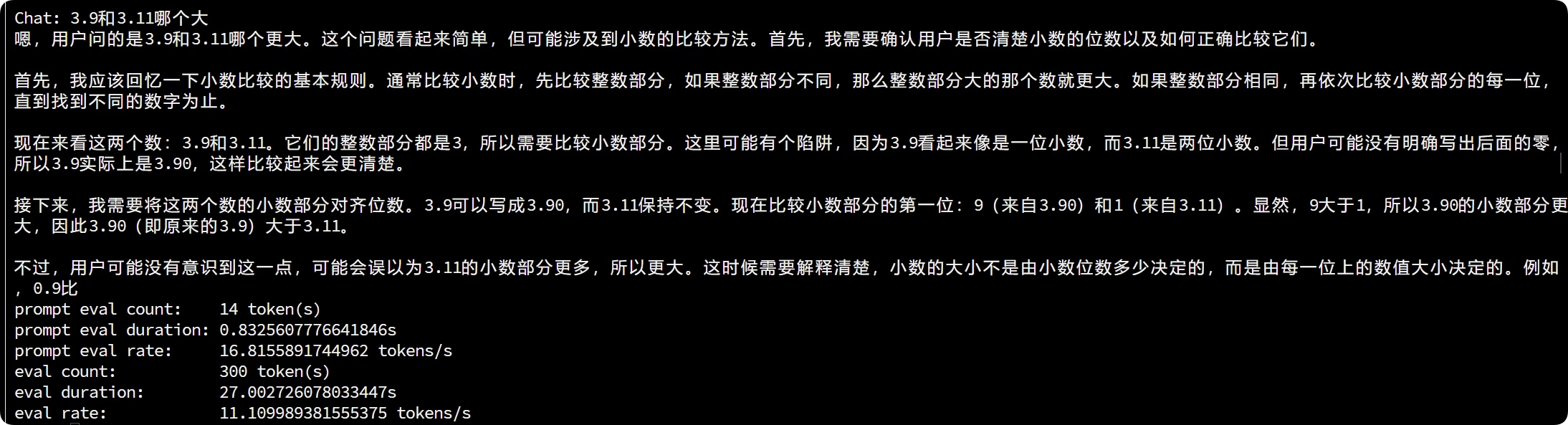

效果测试👇

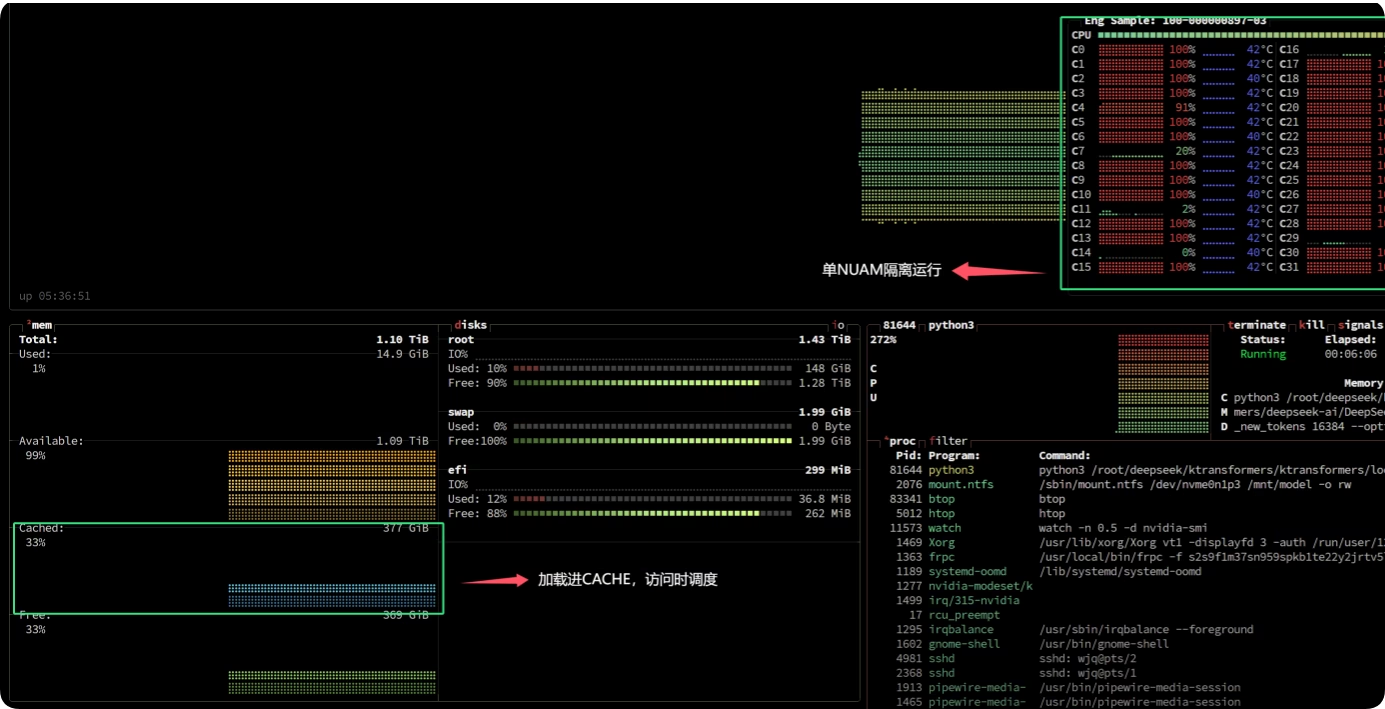

ktransformer主要是将整个模型分为两部分:

- 专家模型交给CPU侧 Q4量化版本下大约cached 380g内存

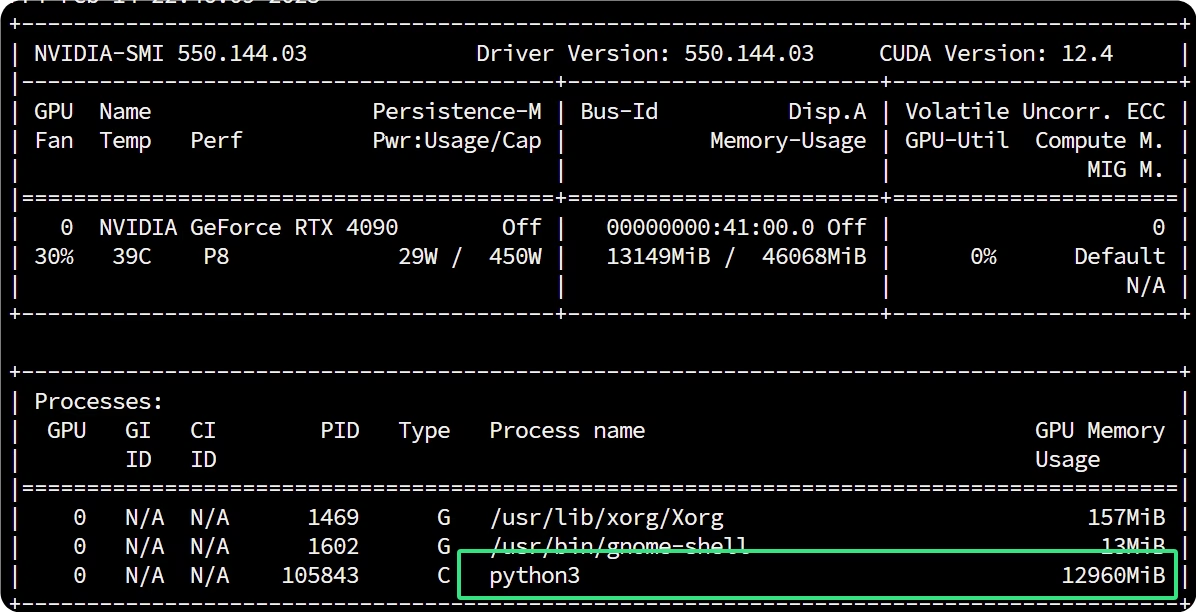

- 注意力交给GPU侧 Q4量化版本下大约cached 13g显存

最后说说整机具体配置:

- 双路 EPYC9334QS

- 24 * 48G DDR5 5600MHz

- 1 * NVIDIA 4090 48G (实际过程用不到这么高的配置,这配置都可以双开,每个numa单独跑了😂😂)

3

牛逼👍

不知道这个瓶颈是在什么地方,内存带宽么?ddr4的服务器内存是真的便宜,插满512G花费才2100足够了

嗯 内存带宽始终都是最大瓶颈 其次就是cpu了 志强支持amx应该会好很多 gpu反倒不怎么吃