AlphaArea

那两个M.2也是纯SATA的吗?

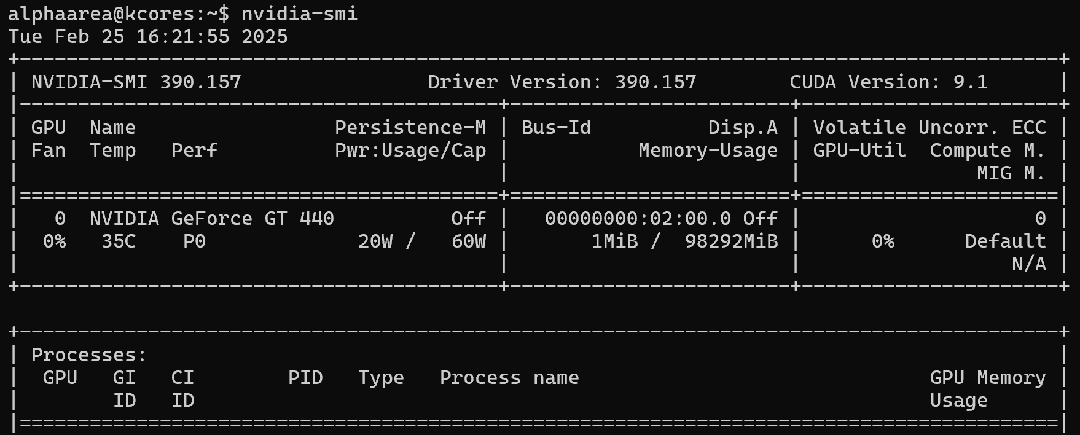

等395能正常起vllm再吹AI的牛逼吧

现在纯装ROCm都要靠

HSA_OVERRIDE_GFX_VERSION=11.0.0

半高涡轮卡,小体积草履虫狂喜

看起来已经没OpenAI什么事了

24x25G?PCIe可以改成SFP28来跑?

第一个x8识别的网口能link up吗?来个终端截图看看?

那82599要成永远的传奇了

我看有人测了说MiMo-VL没有安全检查,可以直接生成FBI Warning

有种既精致又粗糙的感觉

-

捡OCP洋垃圾是因为它便宜。OCP转雷电卖个四五百,又要逼逼不如加点钱买一体式雷电万兆网卡了。

-

雷电自带20GbE软网桥。虽然实测性能一坨屎,但截图装逼看起来比万兆洋垃圾屌多了。既然要当雷批,为什么不全买带雷电的设备互联?

这还不算PCIe强行热插拔可能导致各种蓝屏问题

👊⚡🔥

雷电+穷逼=雷批

-

我觉得LLM跑分跑5-shot就已经够离谱的,原来还有更离谱的

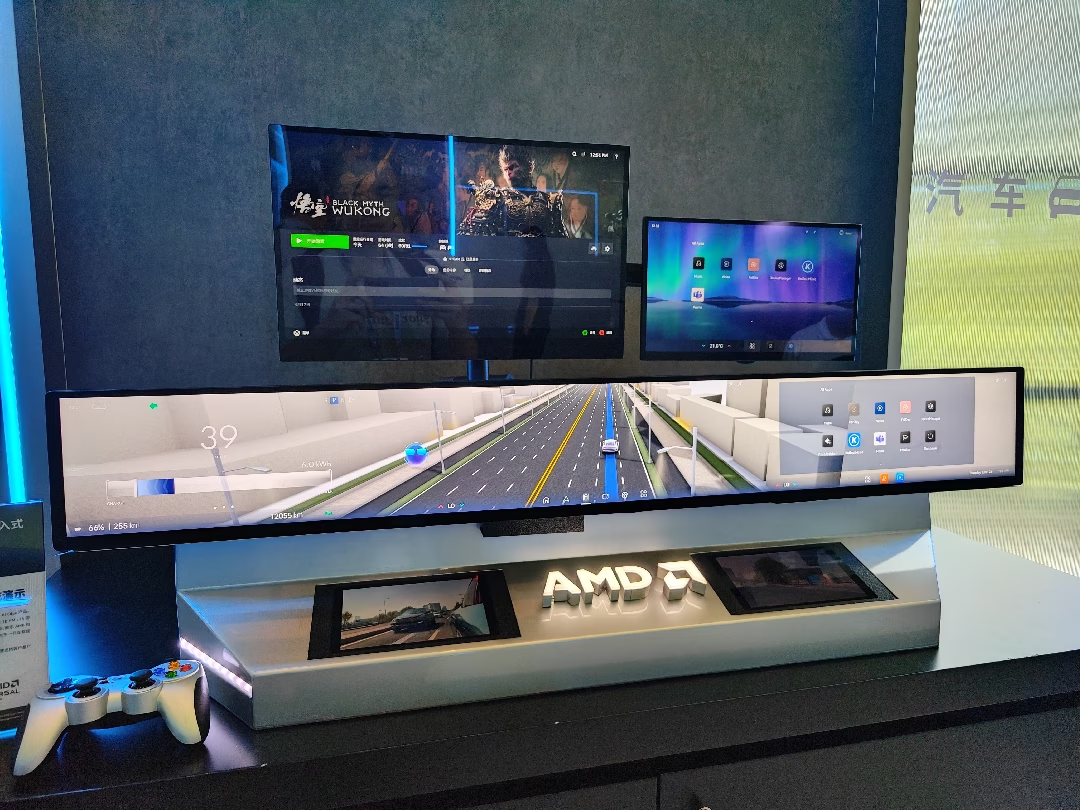

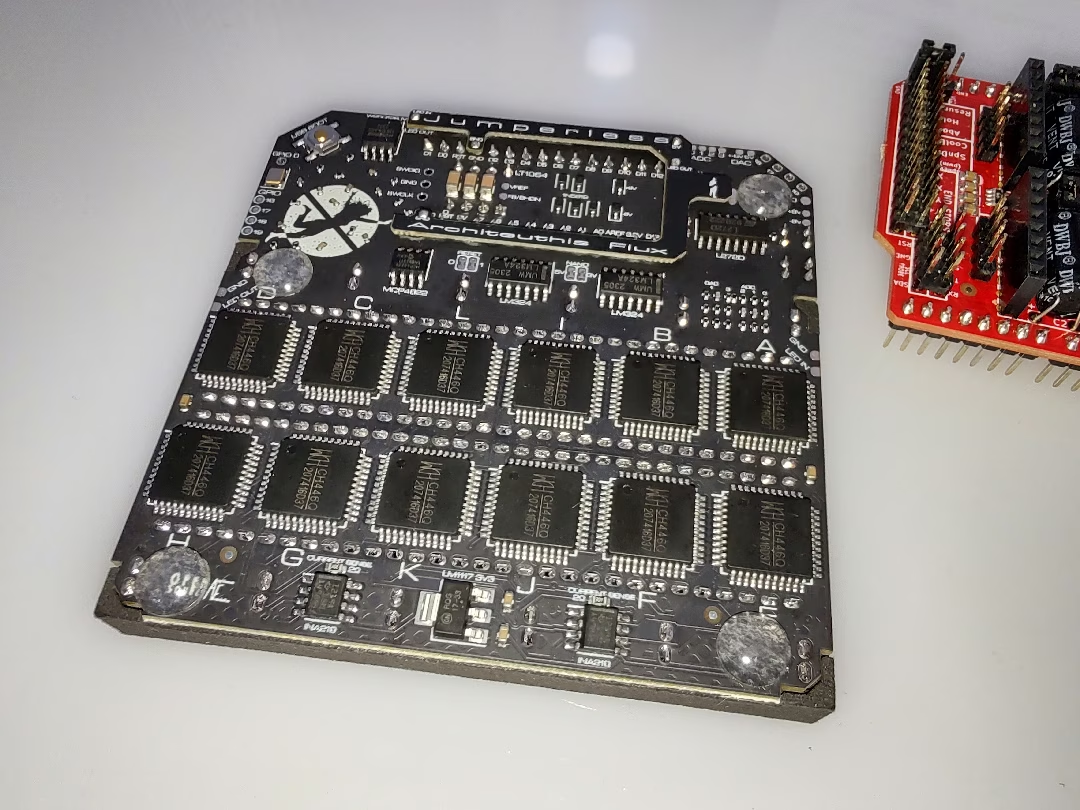

那么多A380……主要功能是跑视频编解码吗?

C64就算带上扩展内存也装不下现在主流的分词器,更别说模型了,不知道运行的是个什么鬼

因为有全新L20 48G(可近似当作4090D 48G)在2.5万的价位压着,实际上现在4090的价格已经涨无可涨。

毕竟魔改48G总得比原厂48G便宜一点吧?显存颗粒和手工费总是有成本的吧?那么现在1万8+的回收价已经没什么利润空间了。

炒卡的要想让4090的价格更上一层楼那就只能来阴的,96G直接超越A100 80G,更重要的是96Gx8正好可以运行满血deepseek-r1,这下4090 96G的价格卖到10万也不是梦了。

但问题是4GB(32Gb)的GDDR6/GDDR6x颗粒从哪来呢?

反正赚到钱的都跑了,买不到显卡的可以来评论区吐槽…

打原神能秒骁龙8G2吗?

搞不懂Mali的这坨命名规则

yolo锁头挂要效果好的话,是缩放到640x640输入还是需要做显示器原生分辨率输入?

要是需要做4K原生输入的话,那确实挺需要NPU加速的(

1500带铂金双电的话……当GPU矿机也不是不行(毕竟自己搭矿架配主板电源转接线也快1000了

华为CX5200 V5表面上可以装9块双槽显卡,其实只有4个槽是真PCIe x16,然后这些速率不一的PCIe槽还分别连在两颗CPU上。

低情商:谁家矿机做得这么精致

目测就算华南金牌进军服务器也难以超越的存在

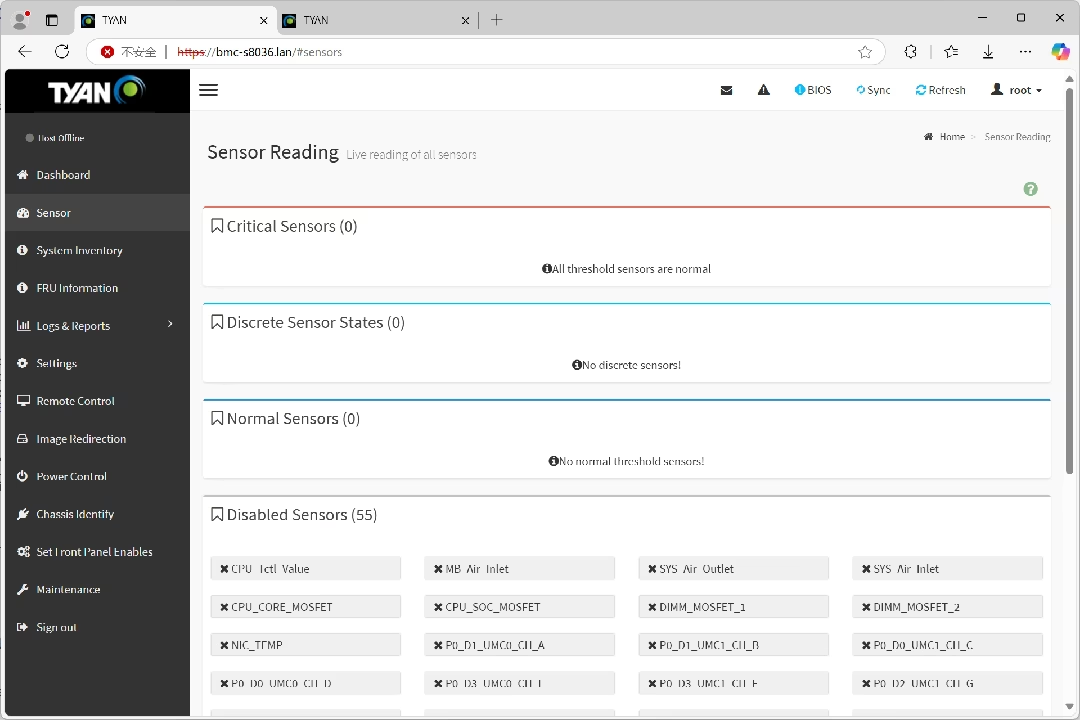

硬件和装配细节都不说了,就说它这离谱的IPMI

别人的服务器IPMI失效都是强制风扇最大转速,泰安的IPMI失效强制风扇最低转速

把EPYC干到热保护关机

我™直接???

上一次热保护关机还是装E5的时候忘装散热器…

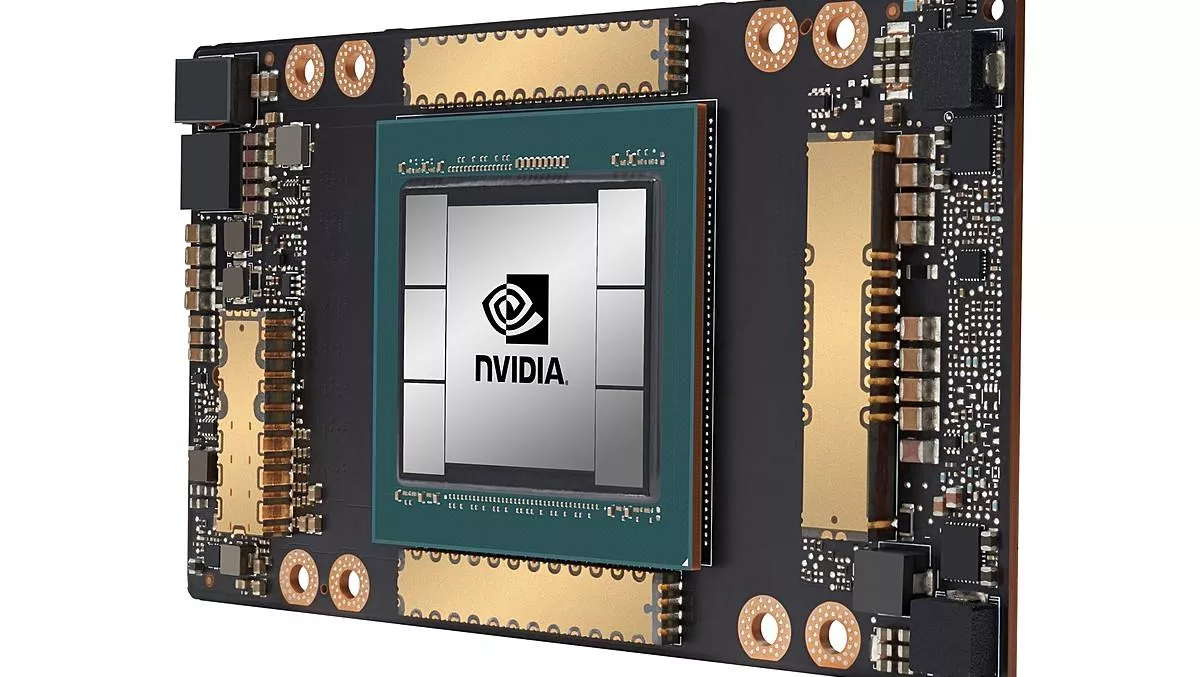

🧐AMX指令集+HBM内存,能不能讲好AI故事?