前言

同步发布于 我的Gist

这篇文初稿写于2025年3月,之前本来计划写好了直接发出来的,兜兜转转一直咕了,最近准备对这套配置做个升级,现在再不发出来就晚了。

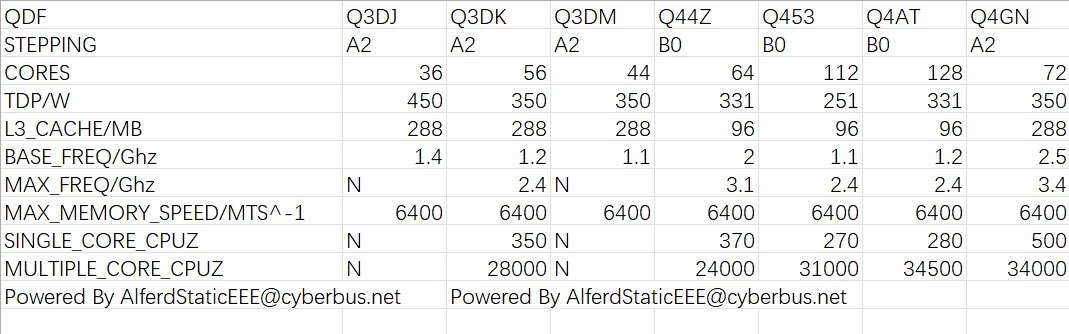

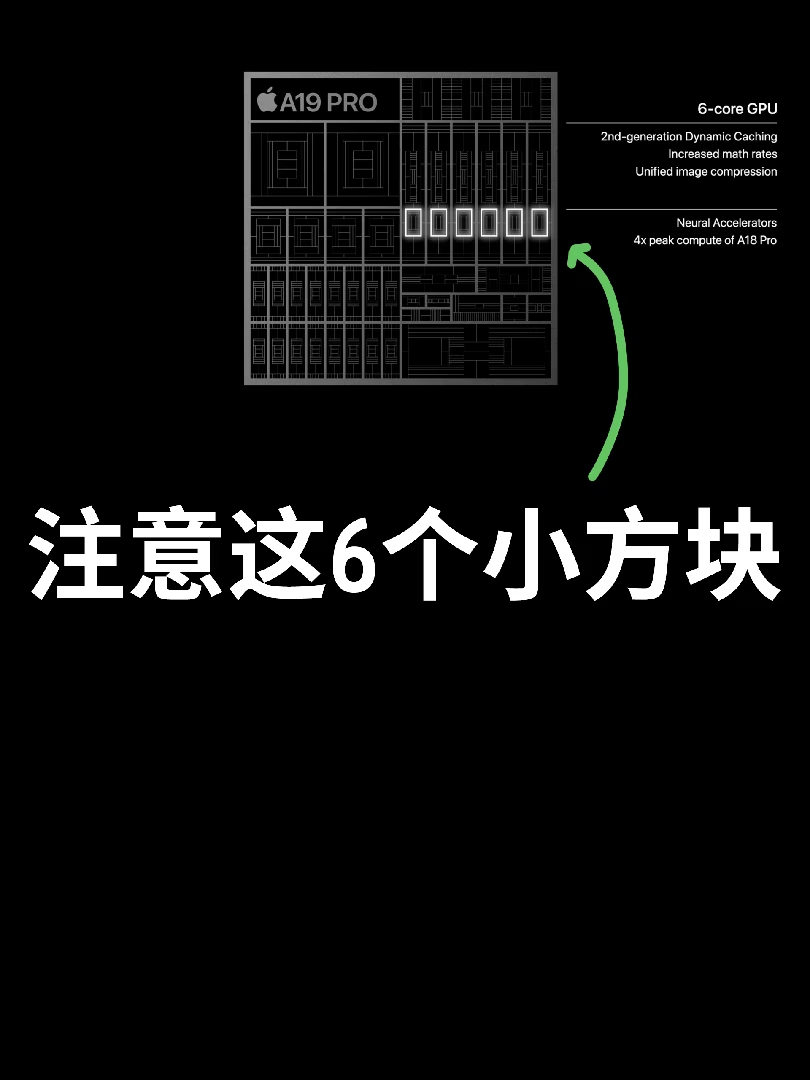

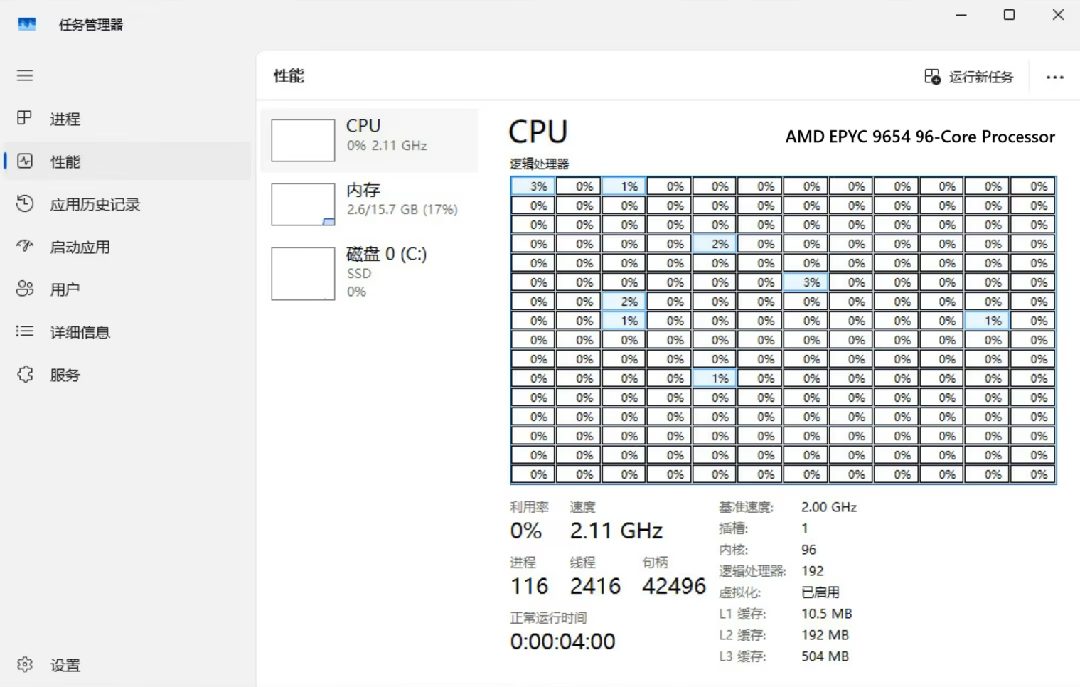

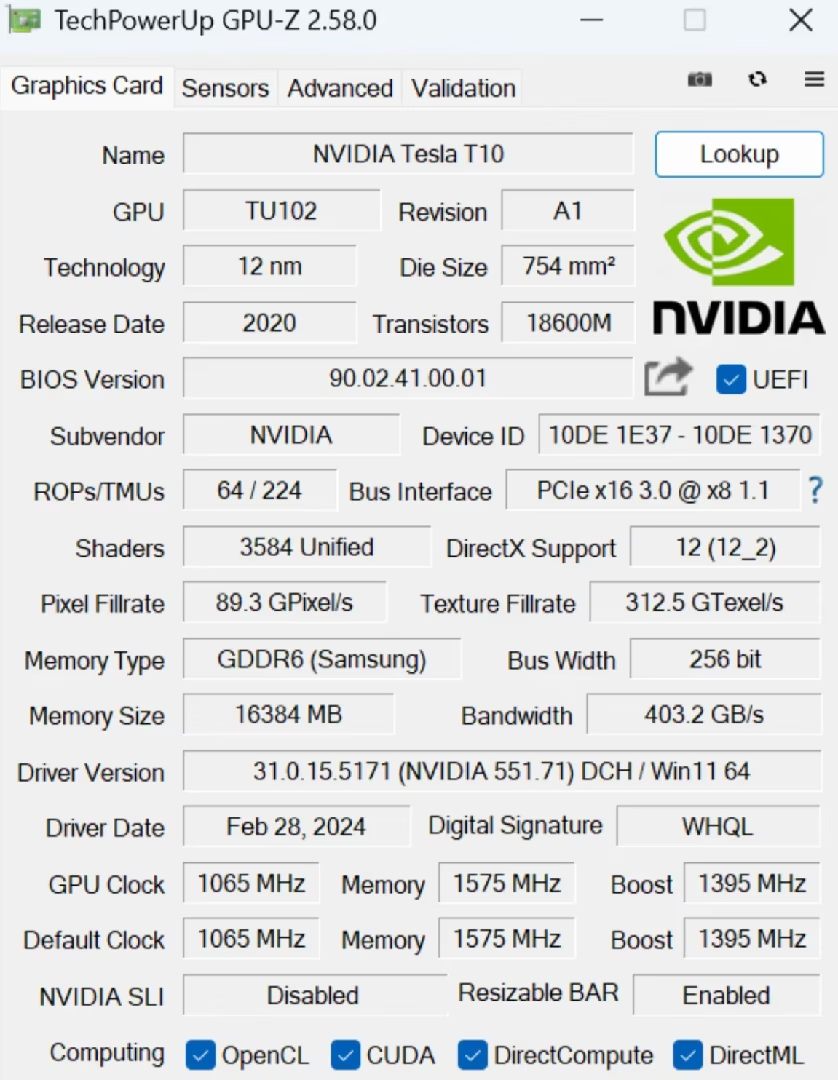

现在来看,选T10性价比其实已经不是那么高,当时做这个配置的时候 2080ti 22G还要2200一块,现在已经跌到1700左右了,T10现在还在1000出头。 2080ti算力更高的同时还支持NVLink,4卡互联应该可以跑起来社区最近比较火的 MiniMax-M2.1-REAP W4A16。…

9364-8i是最后一代支持CacheCade Pro的卡,对机械盘相对友好,价格便宜,量大管饱,所以一直坚守在岗位上,只是散热太弱了,我用服务器机箱暴力风扇要开全速才能压的住(就这还要有56度),风速降点速就直接热的挂机,能热到85度以上。

改造散热后,环境温度21度下,同样的机箱风速自动,保持在49度,全速在38度。效果十分明显。

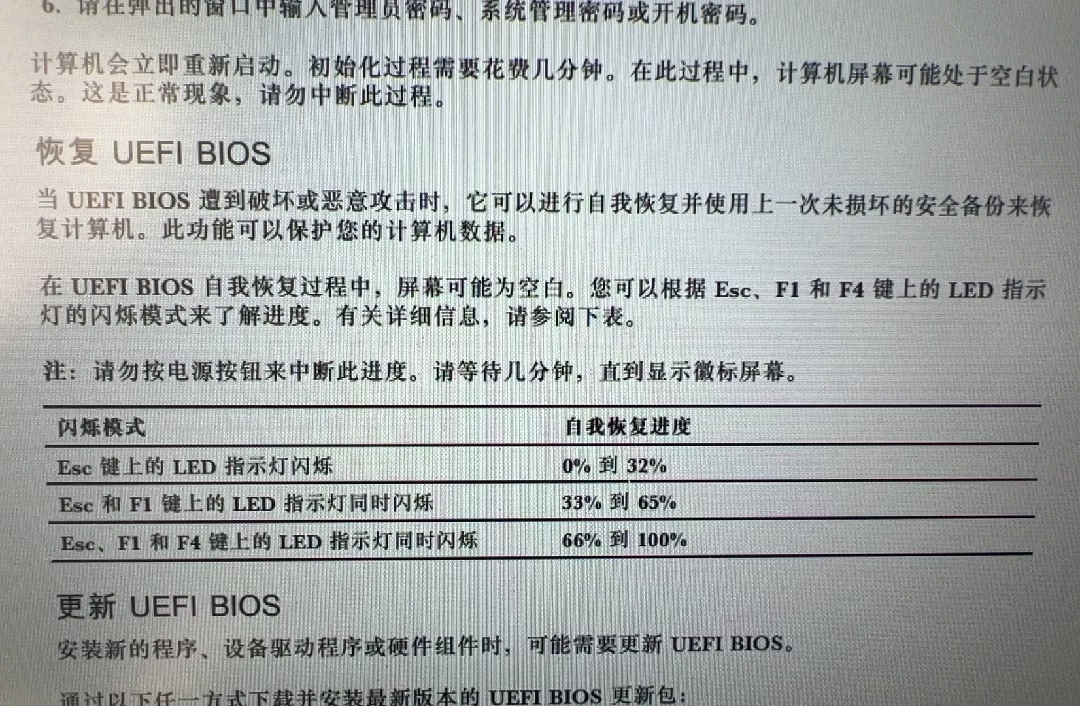

Thinkpad X1 Carbon Gen10不开机键盘指示灯ESC F1 F4依次闪烁 早上开机后突然蓝屏,蓝屏按照提示按回车后正常开机并进入系统。登录企微后又突然蓝屏,进入安全模式失败,通过移动硬盘用Ventry进入U盘启动也蓝屏。按照必应搜索建议捅了D壳重置后开机进入修复也失败,现在显示屏无显示,按开机键后三个按键知识点依次闪烁,官方文档说bios在修复一个多小时了状态还没变。有什么解决办法吗?这样会影响数据吗?

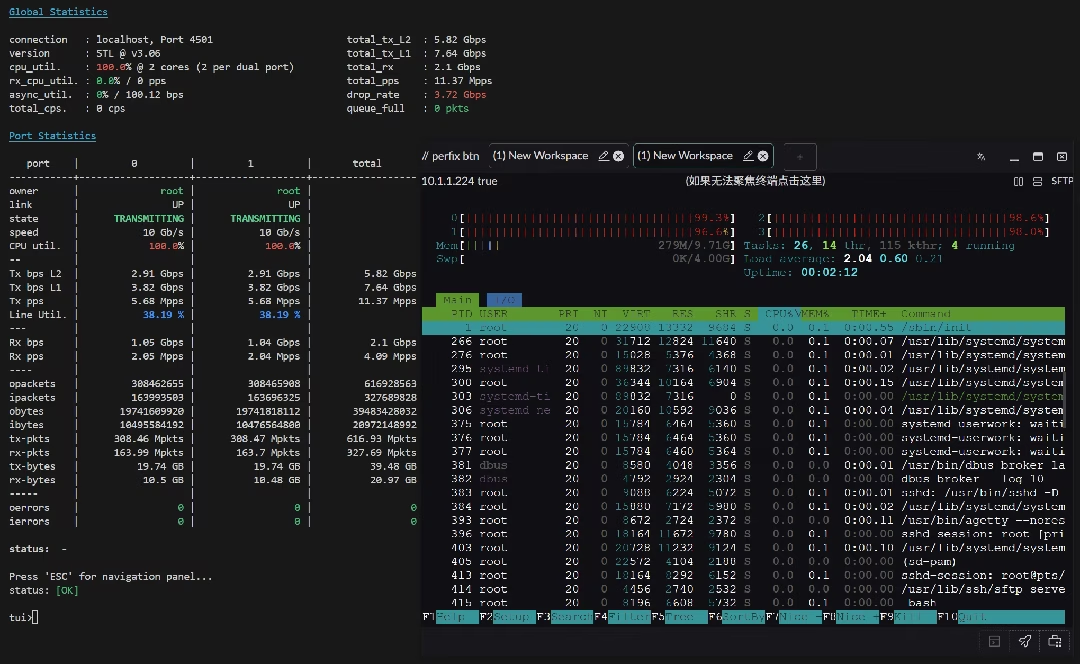

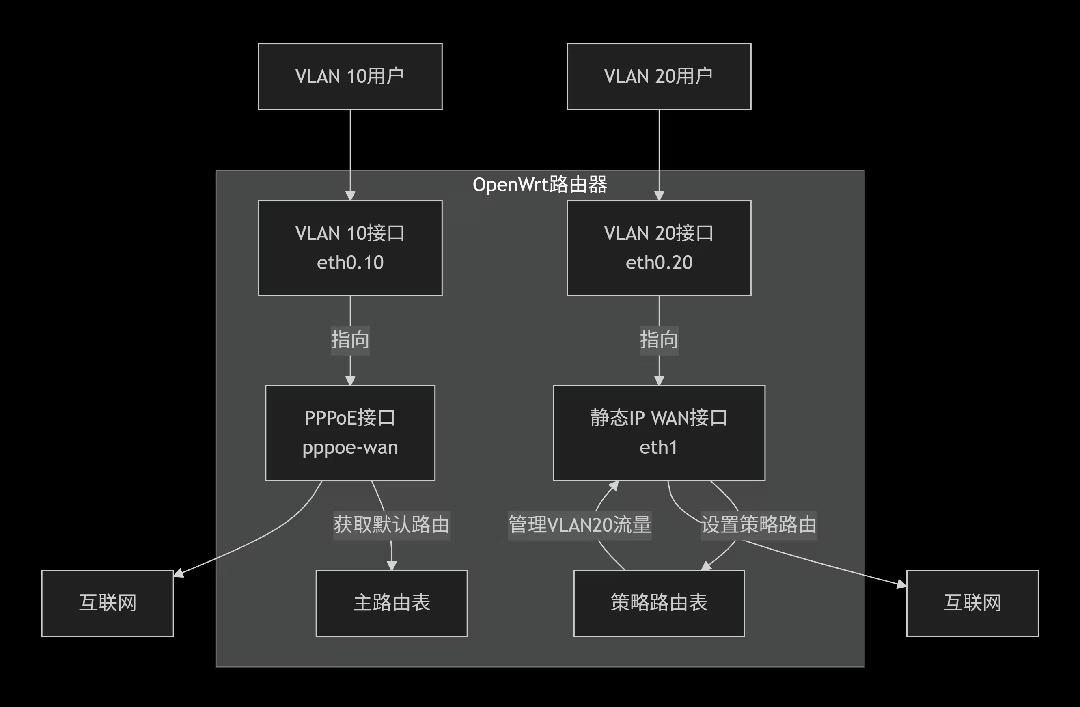

小公司,有一个移动专线套餐,是pppoe+一个固定ipv4, 内网只有办公网络和测软硬件用的esxi,偶尔会用到端口转发把测试环境的端口映射到固定ip上。

目前是把固定v4挂到了usg6307上,pppoe闲置了。

现在手头上有个刷好op的512m 兆能m2,想将pppoe和固定v4一起挂在兆能m2上,然后vlan10走pppoe,vlan20走固定v4。 问了ds,ds让我配置mwan3,但是实际配置后都实现不了想象中的效果,要么就是一起走pppoe,要么就是一起走固定v4。

在站里逛了逛,大多数帖子都是与PC、服务器、NAS等功能性系统产品有关,而少有关于电子测试测量仪器的帖子;既然是硬件相关论坛,没有测试测量仪器的有关讨论那怎么行?正好最近捡了一台多通道可调电源,跟各位分享一下心路历程;如果有什么问题,还请各位大佬不吝赐教!

事情是这样的:那天在深水鱼上面逛,看到了这台ITECH IT6322;看卖家描述,这台IT6322箱说全,就是库存的全新货,但是却开机黑屏,无法使用,打开发现有一颗电阻烧糊了;正巧我手头上只有一台开关电源,想攒一台鼎阳的SPD4323X,用作模拟,有纹波控制要求以及需要多路电源的电路调试,有时候调试维修,电路板需要两路或者三路直流电压输出,只有一台单通道直流电源就显得很尴尬,需要配一堆降压模块和额外接线;再加上艾德克斯的线性电源口碑不错,不少人评价甚高,早就想拥有一台,可惜财力不足。刚好碰上了这台IT6322,而且每天都在看各位大佬捡漏,早就心痒难耐,跃跃欲试了,刚好这台机子成色也相当不错,基本99新,于是便开始做功课,先看看这台机子究竟能不能修,值不值得赌这一波。

价格1680,D-1747NTE的处理器,应该是22年的东西,还挺新不是老古董,而且接口还不错,单核性能四百多分,20核,完美 的ALL IN BOOM啊 搜了一下,应该是闻泰科技的E310T6 难点是官网搜不到任何文档和手册 大概外观如下图,借的知乎的图片

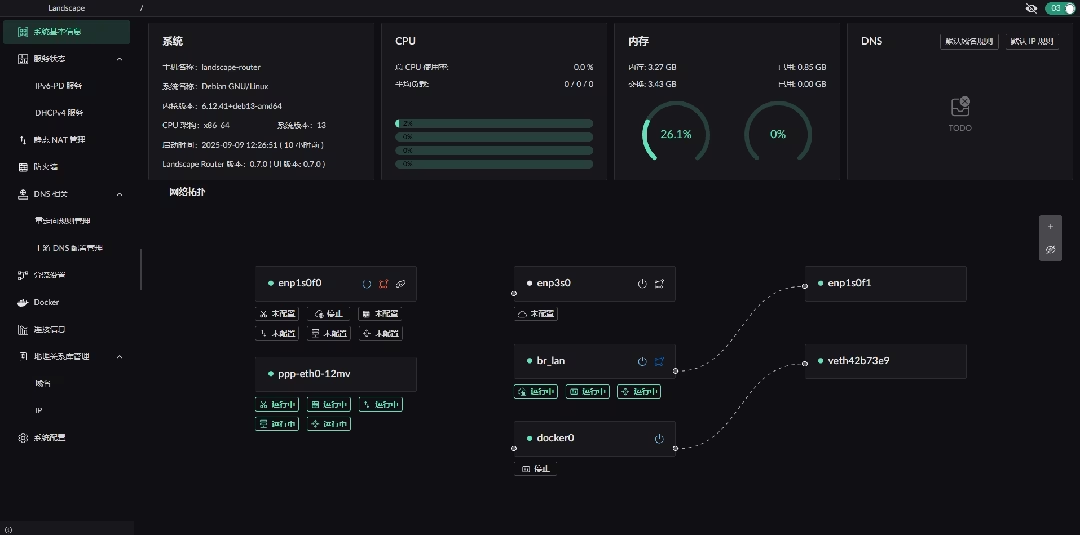

大家好, 我又来更新了.

(新)(v0.7.0)版本新增功能视频演示: https://www.bilibili.com/video/BV1yvYPzDELV

项目地址: https://github.com/ThisSeanZhang/landscape

当前界面截图

来自 esologic 老哥的新设计, 使用树莓派 pico 作为控制器搭载3个风扇驱动, 可以给服务器用的被动散热显卡使用小风扇进行散热, 可以有效节省机箱空间.