给大家挖一下刚刚 Apple 发布会上对于搞AI的同学最重要的信息——

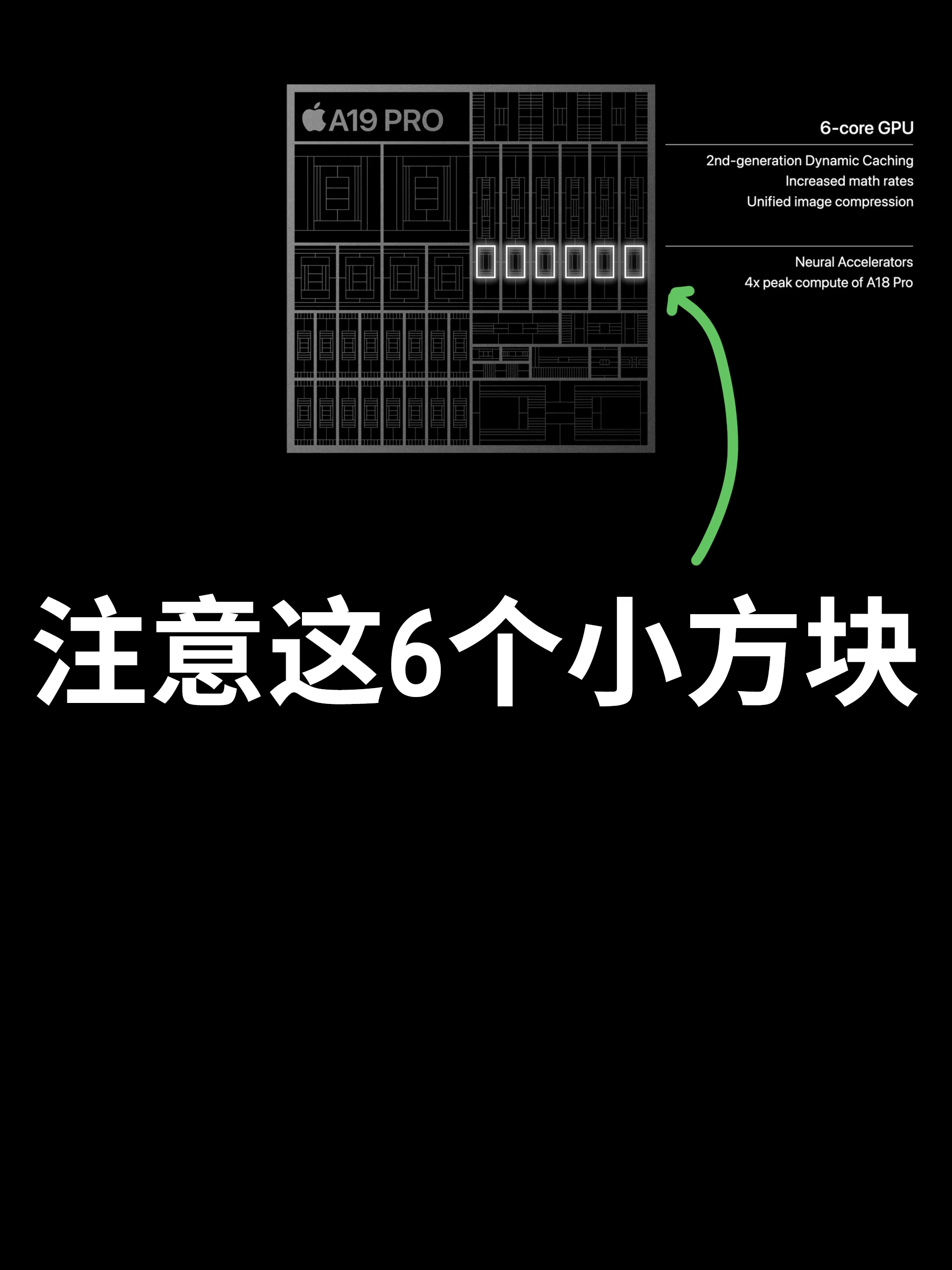

GPU要带矩阵乘法加速单元了!

要知道 Apple 的 GPU不像 NVIDIA 显卡一样是没有 Tensor Core 的, 而老黄的卡之所以快不但是因为浮点算力大,显存带宽高,重要的一点就是 Tensor Core。

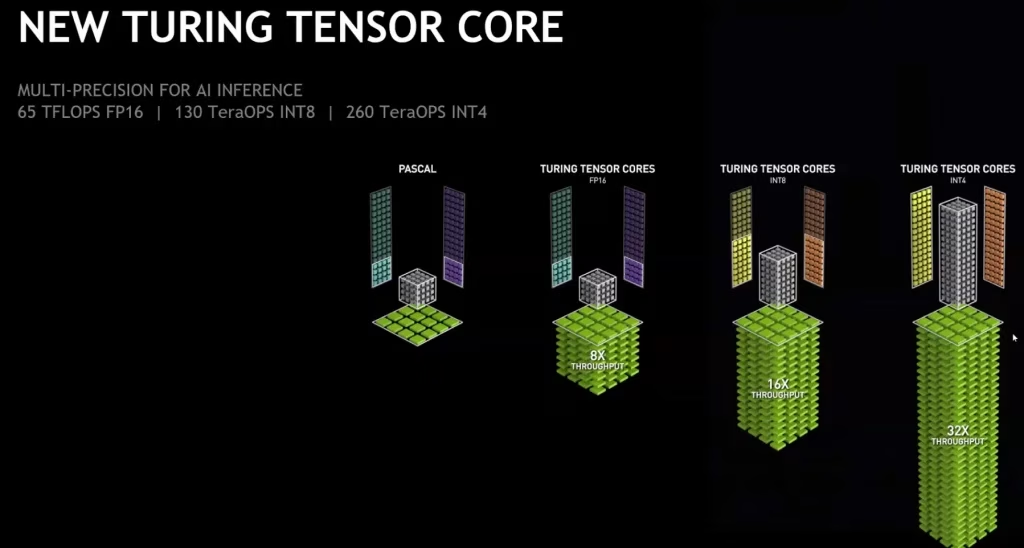

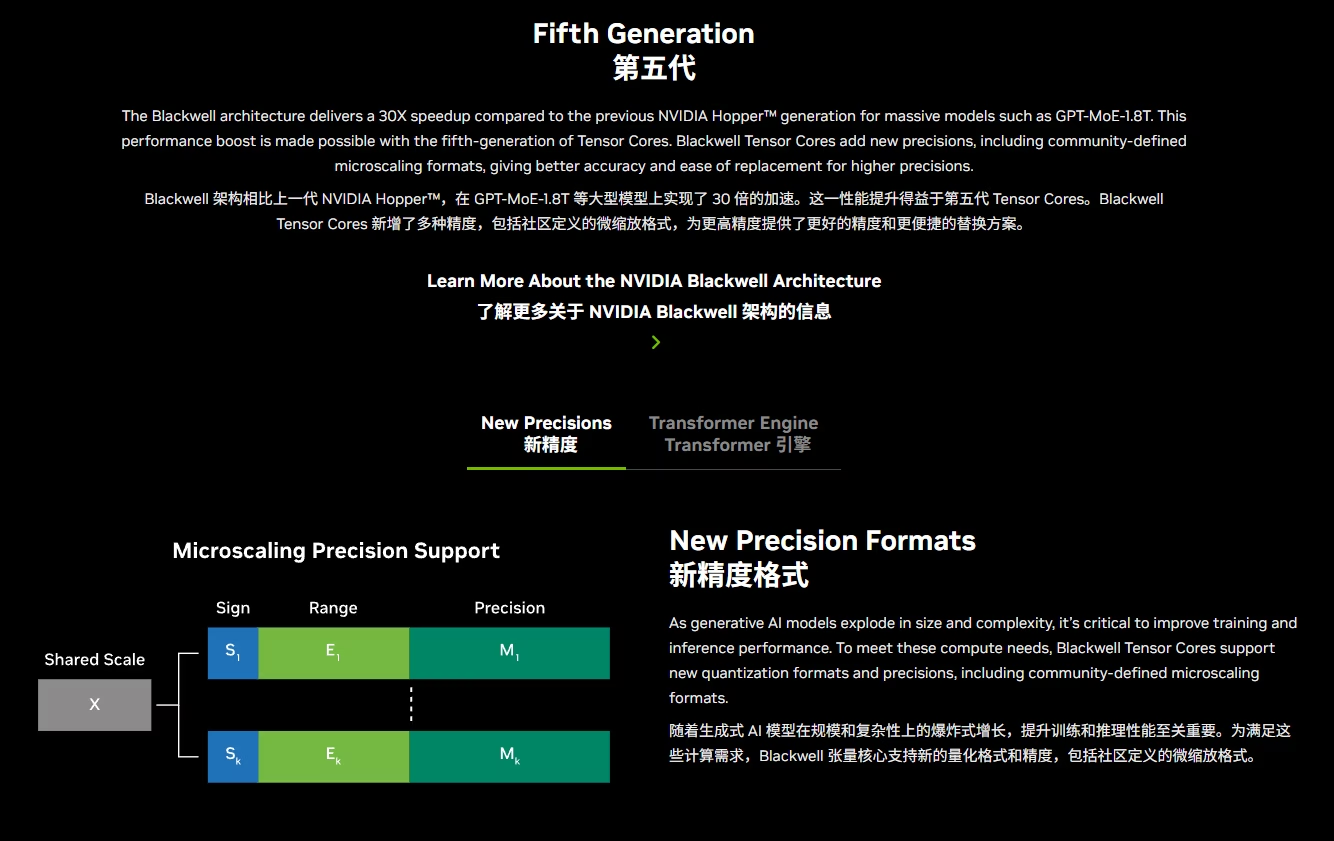

最新一代的 Tensor Core 支持精度包括 FP64, TF32, BF16, FP16, FP8, INT8, FP6, FP4 ,这些都是原生支持的,能搭配各种针对大模型训练和推理引擎的优化。

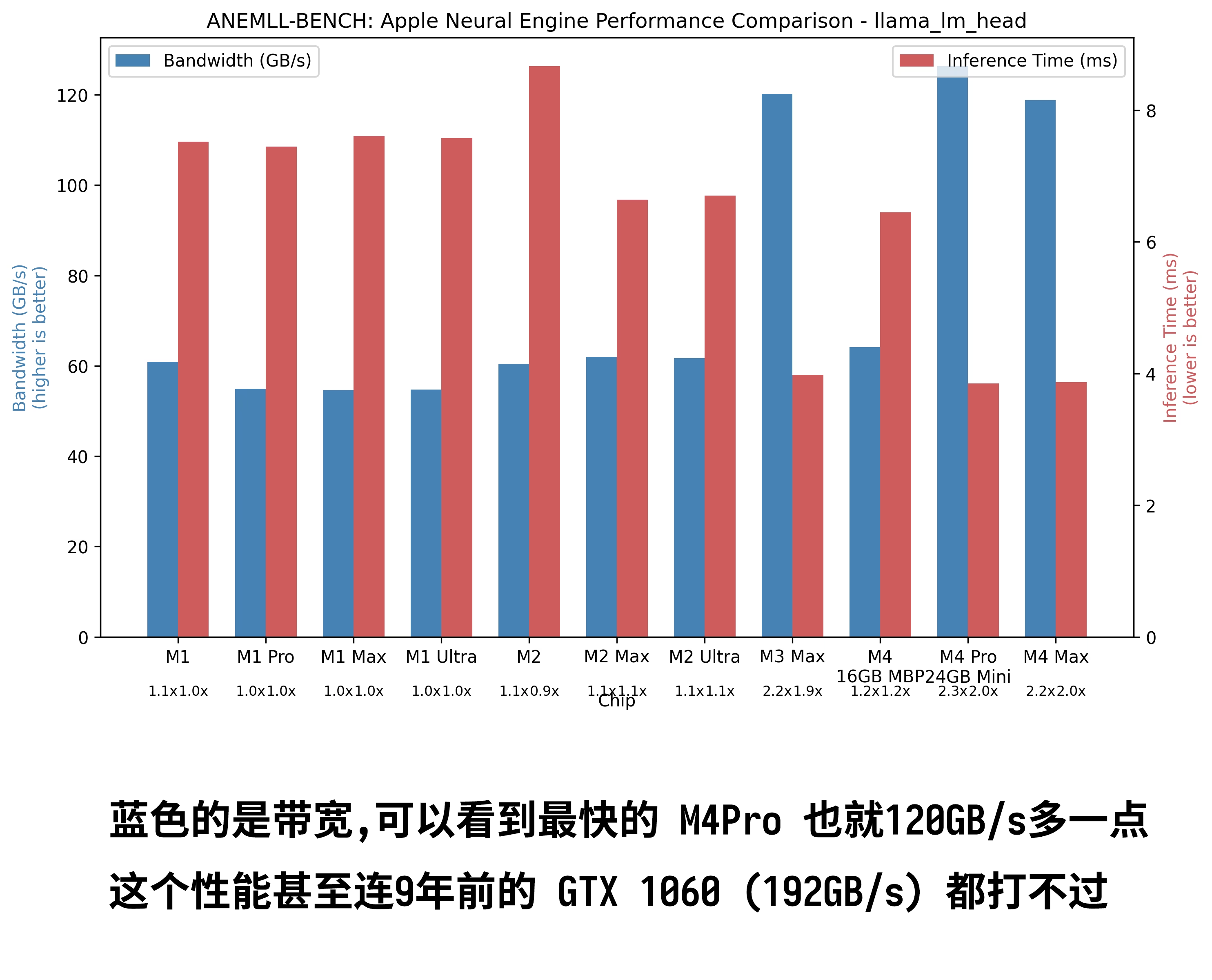

有同学会问,苹果不是一直鼓捣自己的神经网络引擎 ANE 嘛?但实际上应该是单纯 Apple 赌错了,ANE 不但使用难受(需要将模型转换成 ANE 接受的格式才能运行),而且性能也低 (主要是苹果没想到 transformer 架构的大模型会火起来,而 transformer 架构的模型巨吃内存带宽),使用 anemll-bench 测试,ANE 的最大带宽 也就 120GB/s +, 甚至连 2016年推出的 GTX 1060 都打不过. 所以现实中几乎没人用苹果的神经网络引擎(ANE)跑大模型。

但是苹果的GPU就不一样了,我实测我的 M2 Max 几乎能跑 LPDDR5x 的性能的 80%。如果下一代 M5 Max 搭配 LPDDR6,达到 900GB/s 的性能,那就能跟消费级显卡掰掰手腕了(当然是入门卡和中级卡,但是架不住老黄不出 96GB 显存的 5070 Ti Super Luxury (我瞎编的型号))。尤其是苹果M4其实已经知道怎么搞了,直接最高搭配了512G统一内存。

静待明年 Apple 放 M5 系列的 MacBook Pro 和 Mac Mini, Mac Studio. AMD 和 Intel (如果还活着),要抓紧。老黄今年的几个 Jetson 和 DIGIT 虽然给够了显存但是带宽捉急(我怀疑老黄就是有牌按着不大所以我天天骂)。明年会是 AP PC 究极之战了,拭目以待。