没必要拉踩吧,其实业界利用sparsity of attention的最佳实践应该是MoE的模型,每层激活少量专家,计算量大大减少,不过这个算是模型架构的问题了,和框架关系不大

Cake day: November 7th, 2024. Joined 1 year ago

这个应该看soc厂商怎么分,之前Qualcomm的soc说是2channel,其实总位宽也就64bit,32bit一个channel

llama.cpp的cpu部分接好也有amx优化,不知道为啥暴会差这么大,是不是参数设置有点问题

之前也用过inwin ms-04,挺好,现在换其他了

rk3588,这个性能不太行呢

可以,真有这显存大小,真得入一个

671B搞不动。。。。

https://betanews.com/2015/12/02/sage-microelectronics-announces-worlds-first-10tb-2-5-inch-ssd/ Sage-Micro Black Disk 10TB

好像很老了,还是dramless的?

中指通。。。

感谢提醒!这里pico的Pwm经过level shifter后其实已经不直接连接到风扇的pwm口了,level shifter用了mosfet,跑个几十毫安应该够

调速得用pwm,所以用了芯片内的pwm generator,然后还得转5v电平,测速直接10k电阻上拉gpio,内部通过中断函数计数就行

偷懒用了个1117降压,还好信号线和pico功率都不大

大佬求问:

- 现在aspeed的ipmi的image还是用squashfs嘛,这样还是比较容易解开

- 另外amd那个agesa代码好像不开源?

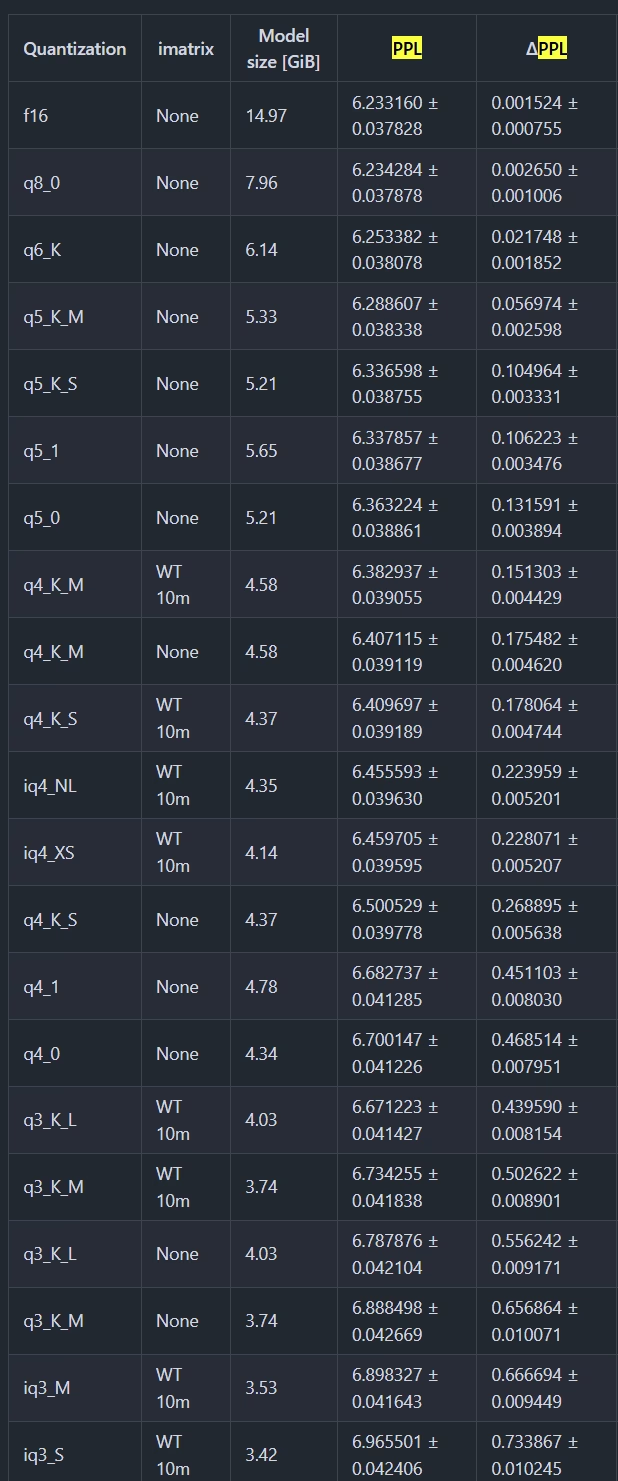

有点极端了,个人认为llama.cpp的pipeline并行做的还可以,而且支持的硬件也挺多,另外也提供了从2bit到8bit的量化,综合起来其实挺适合低端机器

但这样jbod出来的还是两块盘,并不能达到合并成一块比较大的盘的效果呢

好奇这能做到啥采样率,然后存储深度多少?

机柜不错,噪音咋样

Rockchip家的npu好像也不开放编程接口,只能用他的库…