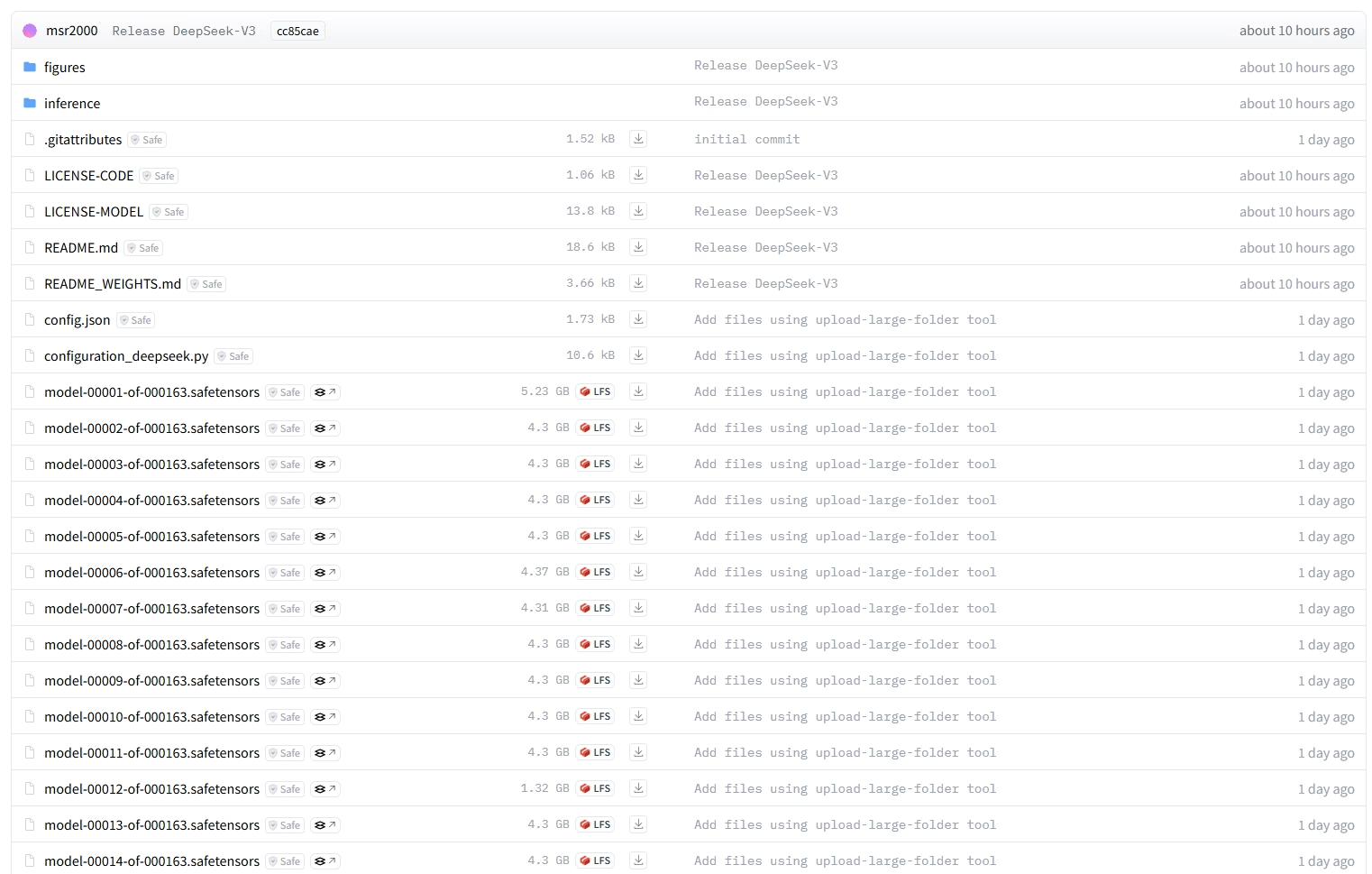

DeepSeek-V3-Base 可以下载了!高达688GB[开学季],而且上传的就是量化后的FP8模型。

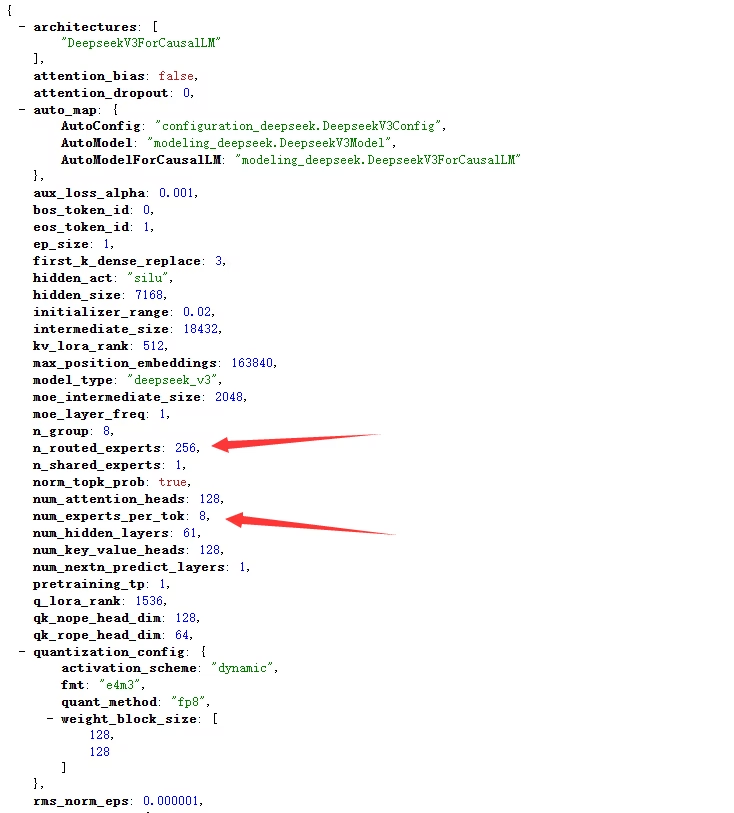

通过配置文件可以看到,总计有256个专家,每个token激活8个。假设每个专家大小一致,那么每个专家就是2.6875GB, 8个专家是21.5GB!假设问题非常内聚,能在16个专家以内完成,那么这就意味着其实激活两跟70B-4bit模型差不多。DeepSeek-V3将很可用。如果量化到4bit,可能会产生质的变化了。(考验存储性能的时刻到了!建议存储性能不要低于10GB/s的读取速度,这样就能在2秒左右完成8个专家的加载了。)

总之是,牛逼!比我预期的小很多(我以为至少要100GB+,我的存储性能能达到20GB/s的读取速度。)。

现在我正在下载,看看能不能运行,以及真实场景会激活多少专家消耗多少显存。

2

这得 8个H200 这样的卡才能跑吧~~~

671B搞不动。。。。