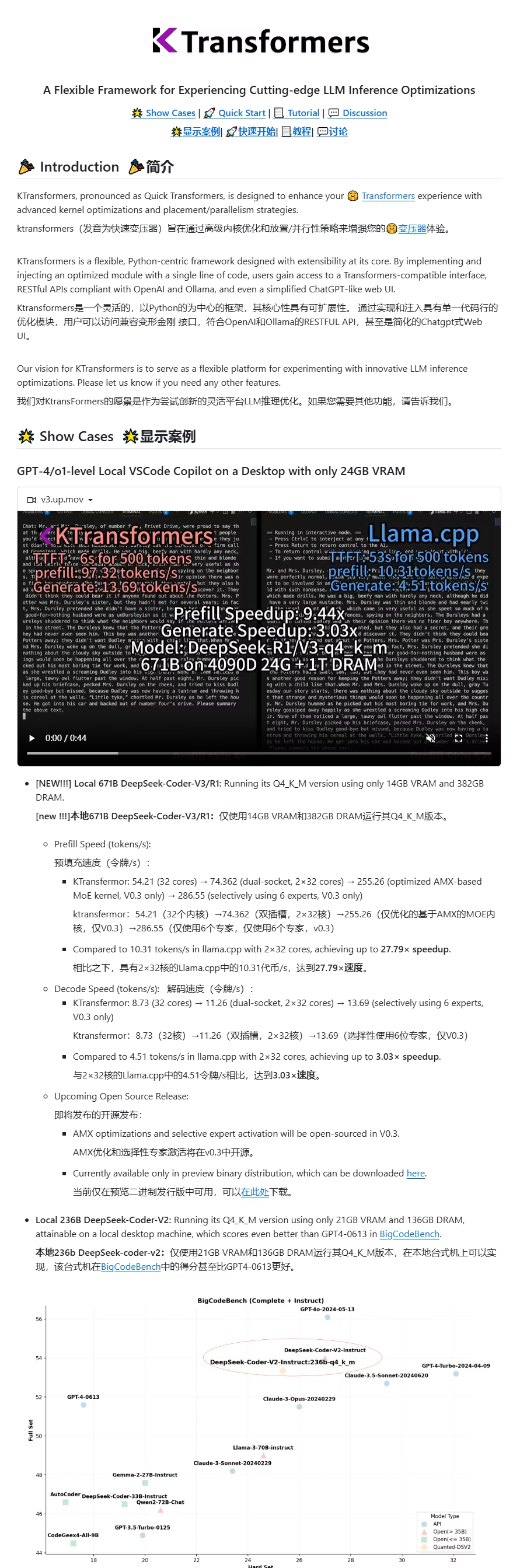

KTransformers 昨天迎来了史诗级更新,通过使用Intel AMX指令集优化,运行DeepSeek-R1 得到了28倍的速度提升!(与llama.cpp相比)

运行教程:github.com/kvcache-ai/ktransformers/blob/main/doc/en/DeepseekR1_V3_tutorial.md

6

llama.cpp的cpu部分接好也有amx优化,不知道为啥暴会差这么大,是不是参数设置有点问题

ktransformers 是利用 sparsity of attention 加速的正经 CPU/GPU 混合推理框架

llama.cpp是纯粹的pipeline parallelism草履虫,除了代码简单蹭新模型热点速度快以外,就别指望它有任何性能亮点了

没必要拉踩吧,其实业界利用sparsity of attention的最佳实践应该是MoE的模型,每层激活少量专家,计算量大大减少,不过这个算是模型架构的问题了,和框架关系不大

不知道…不过我AMX要4代铂金,感觉群垃圾佬上3代铂金的都少…

AMX 1代可扩展志强没amx吧.

内存涨疯了,去年1500的96g ddr5我嫌贵没买,今天看了下要2900