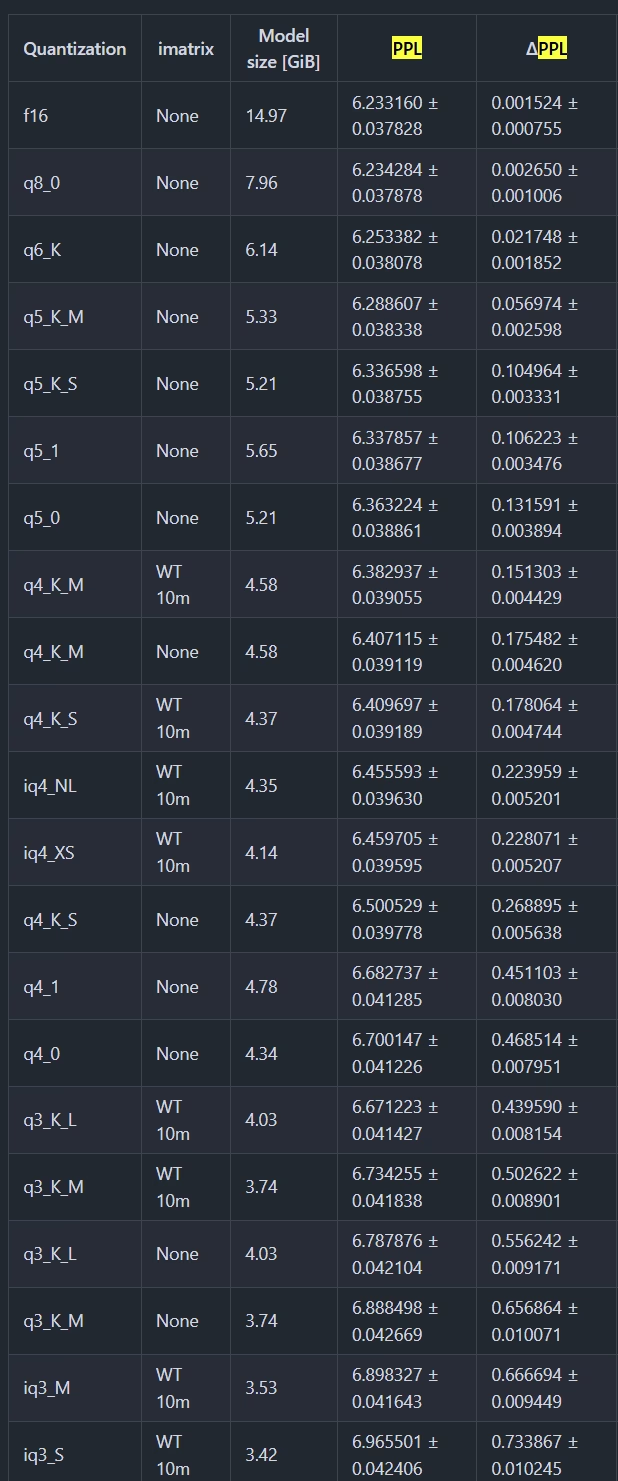

分享一下 llama-3.3-70b 不同量化版本之间的大小和性能描述

| 文件名 | 量化类型 | 文件大小 | 分割 | 描述 |

|---|---|---|---|---|

| Llama-3.3-70B-Instruct-f16.gguf | f16 | 141.12GB | true | 完整的F16权重。 |

| Llama-3.3-70B-Instruct-Q8_0.gguf | Q8_0 | 74.98GB | true | 极高质量,通常不需要,但最大可用量化。 |

| Llama-3.3-70B-Instruct-Q6_K_L.gguf | Q6_K_L | 58.40GB | true | 使用Q8_0进行嵌入和输出权重。非常高的质量,几乎完美,推荐。 |

| Llama-3.3-70B-Instruct-Q6_K.gguf | Q6_K | 57.89GB | true | 非常高的质量,几乎完美,推荐。 |

| Llama-3.3-70B-Instruct-Q5_K_L.gguf | Q5_K_L | 50.60GB | true | 使用Q8_0进行嵌入和输出权重。高质量,推荐。 |

| Llama-3.3-70B-Instruct-Q5_K_M.gguf | Q5_K_M | 49.95GB | true | 高质量,推荐。 |

| Llama-3.3-70B-Instruct-Q5_K_S.gguf | Q5_K_S | 48.66GB | false | 高质量,推荐。 |

| Llama-3.3-70B-Instruct-Q4_K_L.gguf | Q4_K_L | 43.30GB | false | 使用Q8_0进行嵌入和输出权重。质量好,推荐。 |

| Llama-3.3-70B-Instruct-Q4_K_M.gguf | Q4_K_M | 42.52GB | false | 质量好,大多数使用情况下的默认大小,推荐。 |

| Llama-3.3-70B-Instruct-Q4_K_S.gguf | Q4_K_S | 40.35GB | false | 质量稍低,但节省空间,推荐。 |

| Llama-3.3-70B-Instruct-Q4_0.gguf | Q4_0 | 40.12GB | false | 传统格式,提供ARM CPU推理的在线重新打包。 |

| Llama-3.3-70B-Instruct-IQ4_NL.gguf | IQ4_NL | 40.05GB | false | 类似于IQ4_XS,但稍大。提供ARM CPU推理的在线重新打包。 |

| Llama-3.3-70B-Instruct-Q4_0_8_8.gguf | Q4_0_8_8 | 39.97GB | false | 为ARM和AVX推理优化。需要ARM的’sve’支持(见下文)。不要在Mac上使用。 |

| Llama-3.3-70B-Instruct-Q4_0_4_8.gguf | Q4_0_4_8 | 39.97GB | false | 为ARM推理优化。需要’i8mm’支持(见下文)。不要在Mac上使用。 |

| Llama-3.3-70B-Instruct-Q4_0_4_4.gguf | Q4_0_4_4 | 39.97GB | false | 为ARM推理优化。应在所有ARM芯片上良好运行,不适用于GPU。不要在Mac上使用。 |

| Llama-3.3-70B-Instruct-Q3_K_XL.gguf | Q3_K_XL | 38.06GB | false | 使用Q8_0进行嵌入和输出权重。质量较低但可用,适合低RAM可用性。 |

| Llama-3.3-70B-Instruct-IQ4_XS.gguf | IQ4_XS | 37.90GB | false | 质量尚可,比Q4_K_S小,性能相似,推荐。 |

| Llama-3.3-70B-Instruct-Q3_K_L.gguf | Q3_K_L | 37.14GB | false | 质量较低但可用,适合低RAM可用性。 |

| Llama-3.3-70B-Instruct-Q3_K_M.gguf | Q3_K_M | 34.27GB | false | 质量低。 |

| Llama-3.3-70B-Instruct-IQ3_M.gguf | IQ3_M | 31.94GB | false | 中低质量,新方法,性能尚可,类似于Q3_K_M。 |

| Llama-3.3-70B-Instruct-Q3_K_S.gguf | Q3_K_S | 30.91GB | false | 质量低,不推荐。 |

| Llama-3.3-70B-Instruct-IQ3_XS.gguf | IQ3_XS | 29.31GB | false | 质量较低,新方法,性能尚可,比Q3_K_S稍好。 |

| Llama-3.3-70B-Instruct-IQ3_XXS.gguf | IQ3_XXS | 27.47GB | false | 质量较低,新方法,性能尚可,类似于Q3量化。 |

| Llama-3.3-70B-Instruct-Q2_K_L.gguf | Q2_K_L | 27.40GB | false | 使用Q8_0进行嵌入和输出权重。质量非常低但出乎意料地可用。 |

| Llama-3.3-70B-Instruct-Q2_K.gguf | Q2_K | 26.38GB | false | 质量非常低但出乎意料地可用。 |

| Llama-3.3-70B-Instruct-IQ2_M.gguf | IQ2_M | 24.12GB | false | 质量较低,使用SOTA技术,出乎意料地可用。 |

| Llama-3.3-70B-Instruct-IQ2_S.gguf | IQ2_S | 22.24GB | false | 质量低,使用SOTA技术,可用。 |

| Llama-3.3-70B-Instruct-IQ2_XS.gguf | IQ2_XS | 21.14GB | false | 质量低,使用SOTA技术,可用。 |

| Llama-3.3-70B-Instruct-IQ2_XXS.gguf | IQ2_XXS | 19.10GB | false | 质量非常低,使用SOTA技术,可用。 |

| Llama-3.3-70B-Instruct-IQ1_M.gguf | IQ1_M | 16.75GB | false | 质量极低,不推荐。 |

如果不差那么几GB显存的话,建议上Q5,质量比Q4好不少

6