解读下 llama-4 三个模型的官方测试数据,几个点:

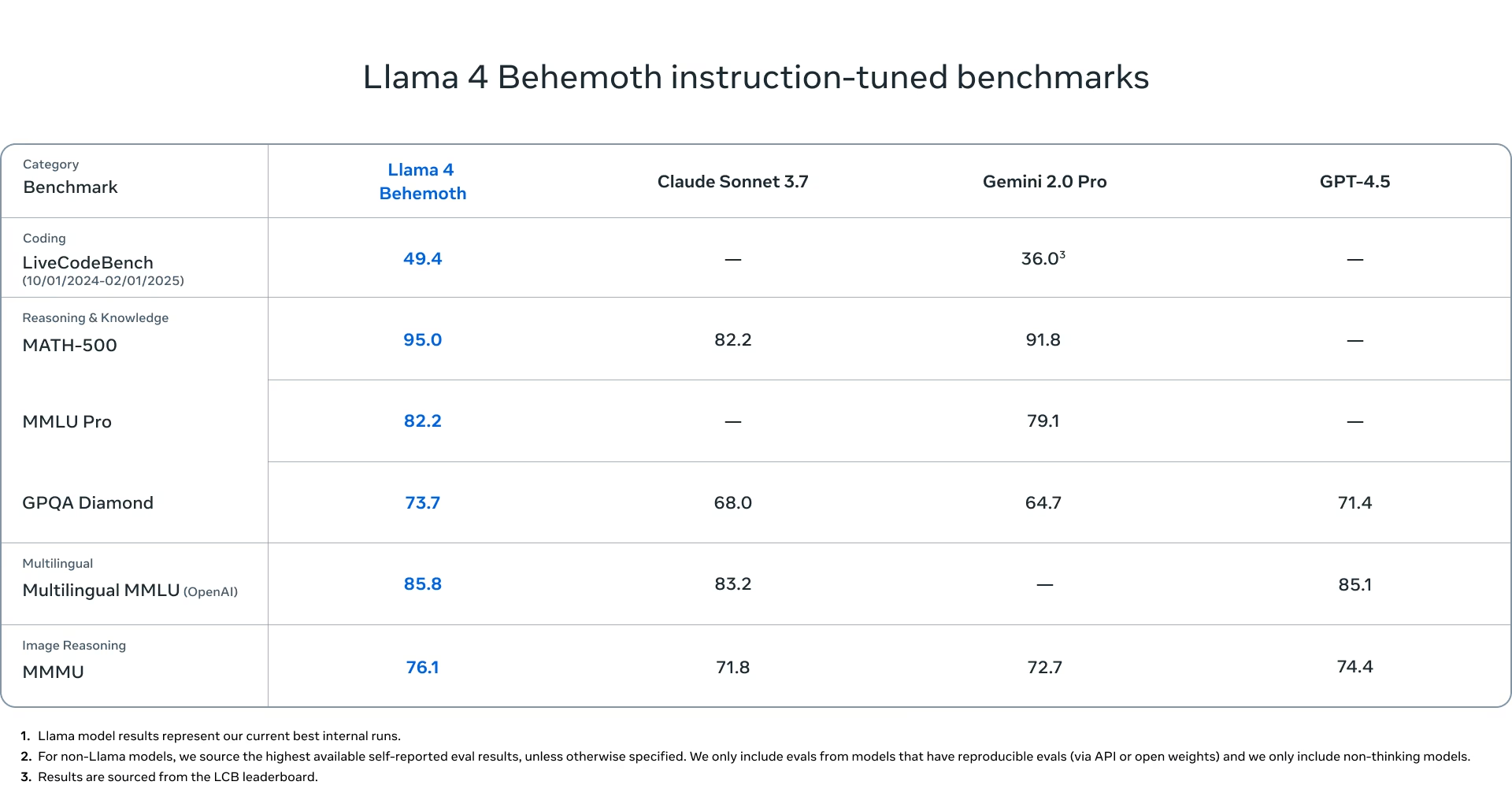

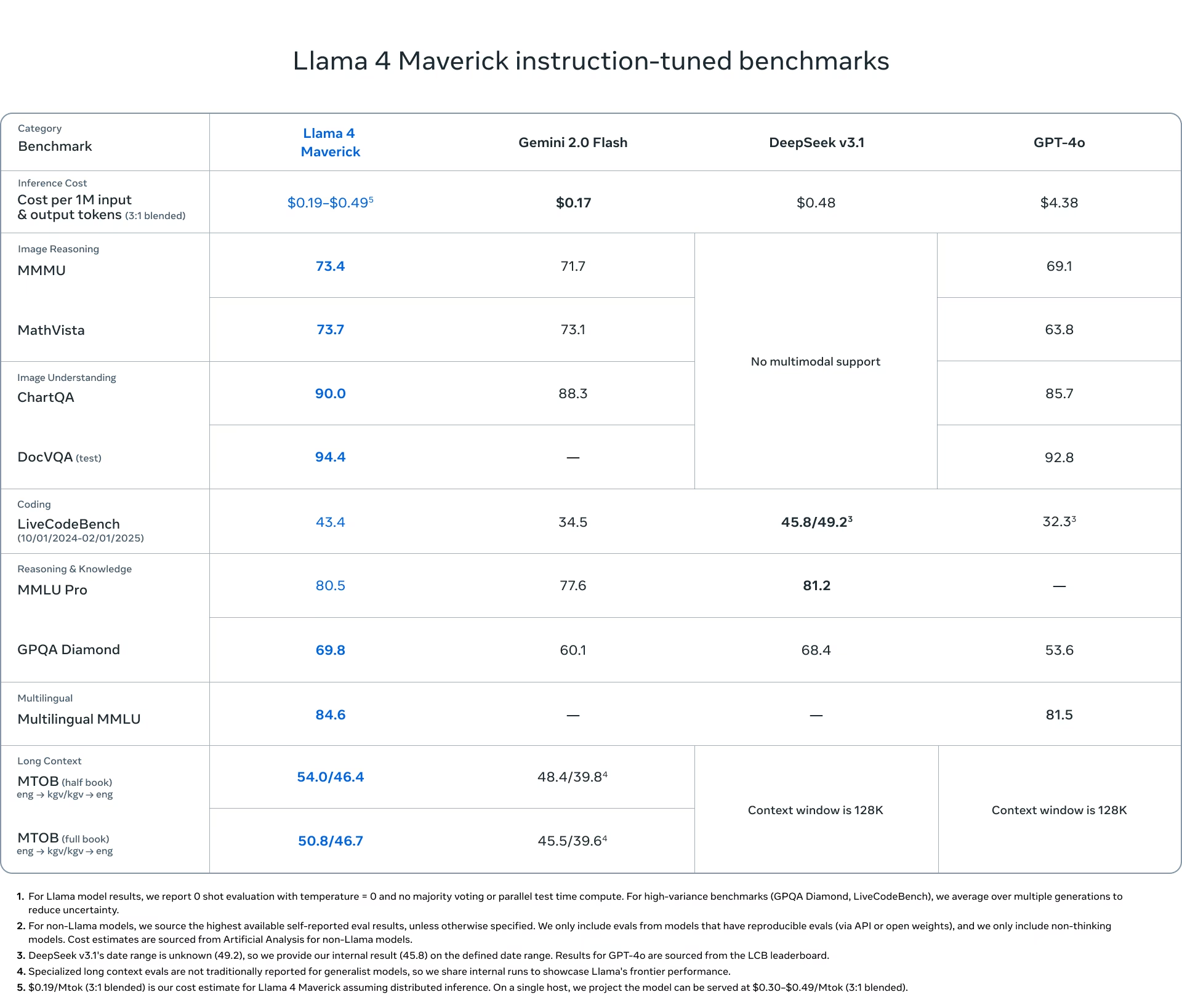

LiveCodeBench 评测 Llama-4-Maverick-17B-128E (402B)写代码是打不过 DeepSeek-V3-0324的,那么 Llama-4-Scout-17B-16E (109B)就更别提了。

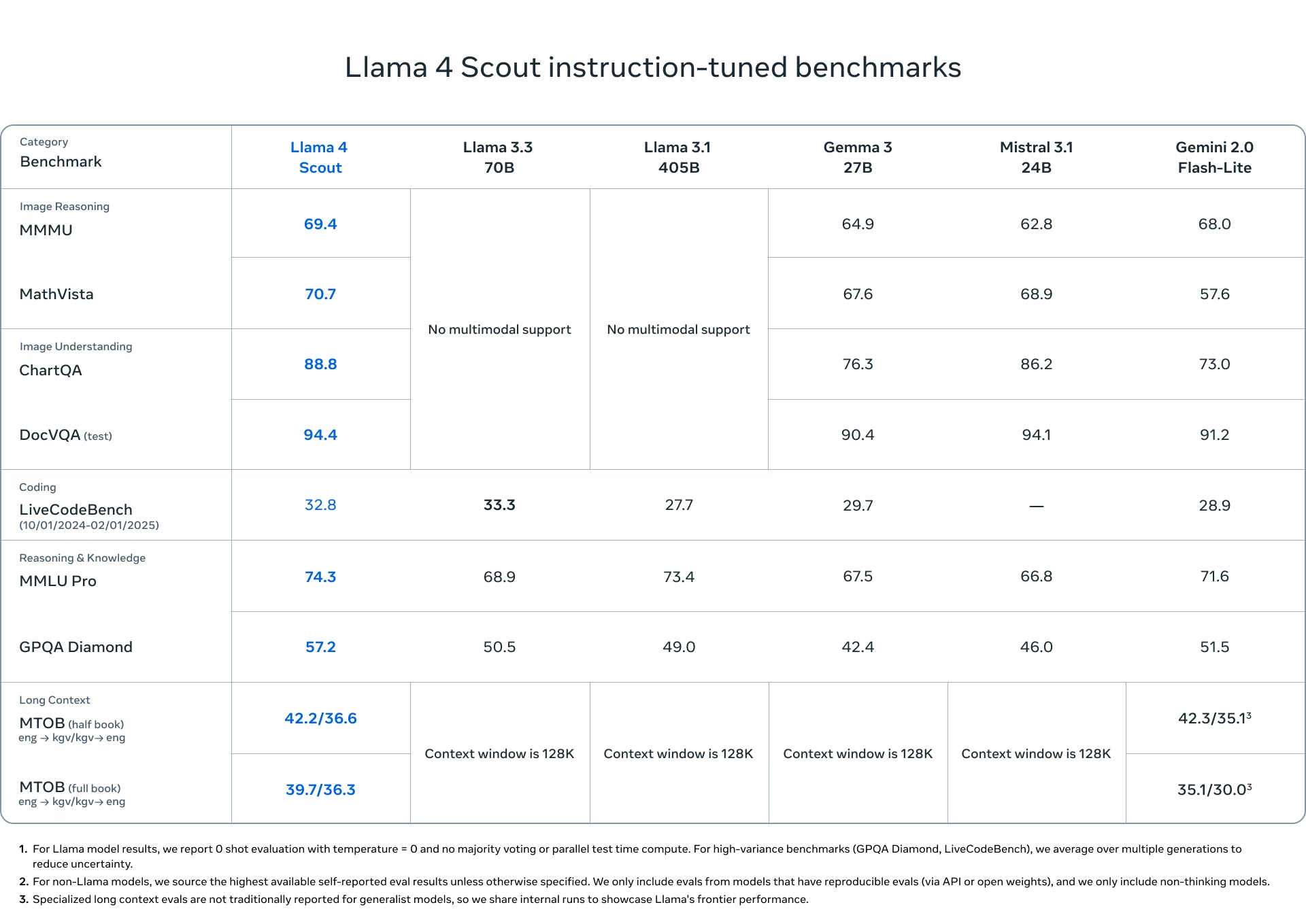

四个多模态测试(Image Reasoning MMLU, MathVista, Image understanding ChartQA, DocVQA)Llama-4-Scout-17B-16E (109B)和 Llama-4-Maverick-17B-128E (402B)是优于 GPT-4o 的。那么 llama-4 应该是开源的最好多模态大模型。

超长文本翻译测试(MTOB)目前没对手,因为对比的几个大部分不支持1M-10M这么大上下文,支持的在大上下文情况下不好。这意味着指令遵循和召回比较不错。

所以 llama-4 的建议场景是超长翻译,以及多模态任务(注意只支持图像输入,不支持图像输出)

1

长上下文通常用于输入较长的参考资料,用于翻译的话输出长度不够。长上下文,成本更低以及同时在文本和多模态任务有较好表现都是优势。后者此前基本只有闭源模型达到。