DeepSeek 可能又要发新模型了!

4月3号 DeepSeek 新发了个论文,题目是<通用奖励建模的推理时间缩放>

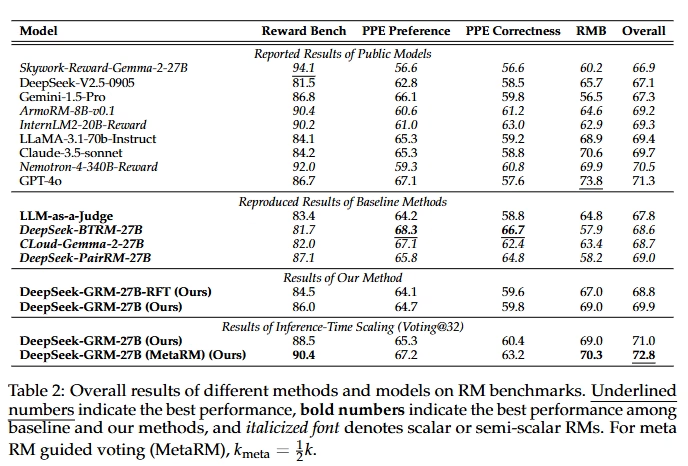

论文中提到了个新模型 DeepSeek-GRM-27B,并且说通过这个论文中的新方法,这个仅有 27B 的模型通过并行评估 (下面会细说) 能达到 671B 的大模型的水平 (DeepSeek-V3 ?)

如果这个真的发布了,Qwen 可是要抓紧研究新方向了… llama-4 则要再次面临致命打鸡飞蛋打草惊蛇? [开学季]

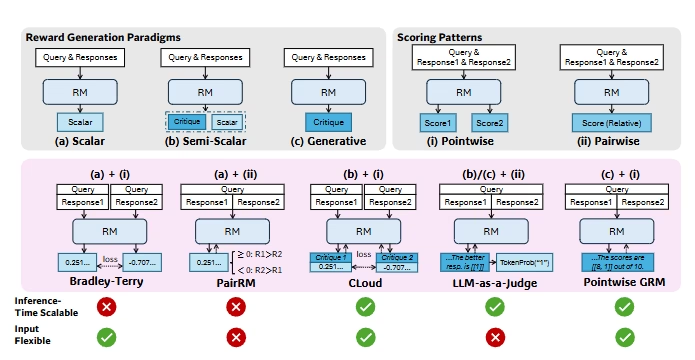

顺便介绍下论文介绍的这个新方法,DeepSeek-GRM 提出了自原理批判性调整(SPCT)这奖励建模方法,这个方法为每个任务生成定制评估原则,然后并行运行多个 DeepSeek-GRM 去评估,最终输出评估后得分最好的结果。

再简单点说,就是用多个(数量可自定义) DeepSeek-GRM 对输出进行打分然后反复反刍,直到得出最佳结果。我理解这个对推理或者写代码可能很有效。但是对于知识来讲应该没太大帮助。比如如果它不知道文艺复兴的相关知识,那么想破脑袋也不知道蒙娜丽莎是谁画的

1

结合llama4的表现,总感觉有种西方不亮东方亮的感觉