大瓜:llama-4 用了 27 个模型刷榜 ChatBot Arena

来吃瓜昨天那个扒 ChatBot Arena 榜单造假的论文, 我看了一遍理了下,主要是这么几个地方。但在此之前,给不熟悉这个测试的同学说下他们是怎么测试的

简单讲,有一个聊天窗口,你可以输入任意内容,然后下面左右两个大模型分别根据你的输入回复,你选择左边的好还是右边的好。选完了才公布模型都是什么。

下面是论文扒的点:

-

偷偷测而且只公布好结果 论文中说,大厂反复刷榜然后根据效果不断微调,Meta在发llama4的时候,测了27个模型!而且只公布了那个分数最高的模型

-

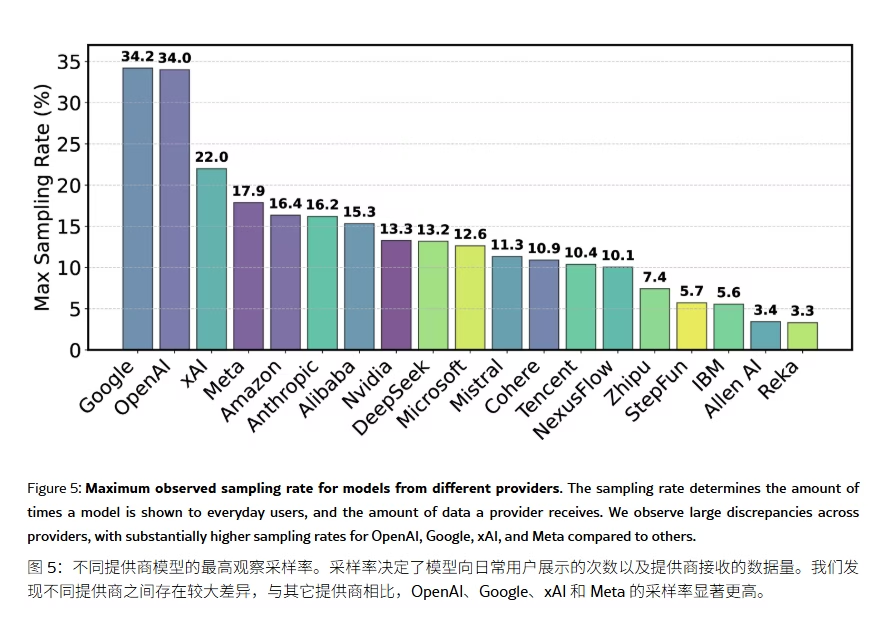

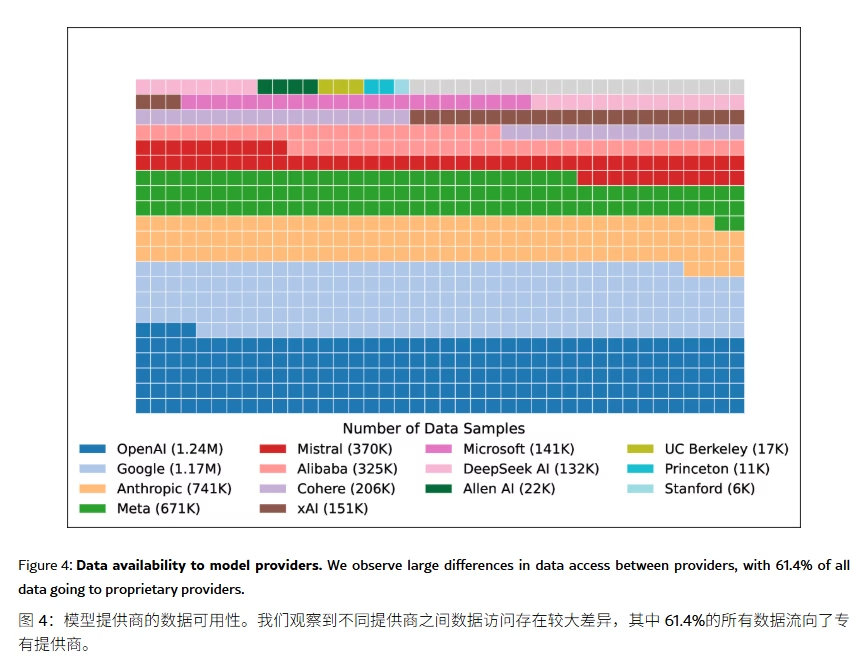

虽然是盲测,但是展示频率造假 Google和OpenAI的模型展示概率是19.2%和20.4%,而剩下的模型中有83个开放权重模型合计只获得约29.7%的评测展示率

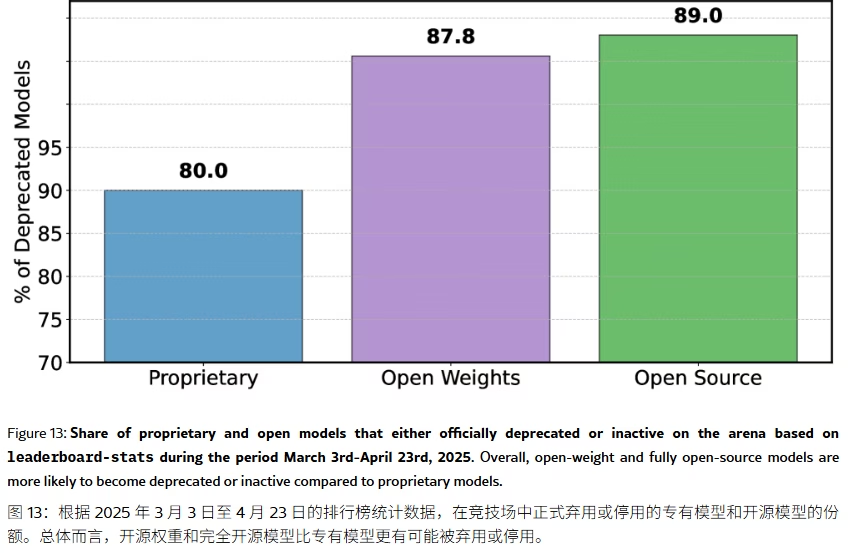

- 模型淘汰缺乏透明度 有些模型展示频率太小,都没聊几次就下架了。在243个公开模型中,有205个平均每次参与不到10场测试。通过统计新模型和头部模型展示概率非常高,开源/开放权重模型淘汰率非常高(86.6%的开放权重模型和87.8%的开源模型被悄悄淘汰)

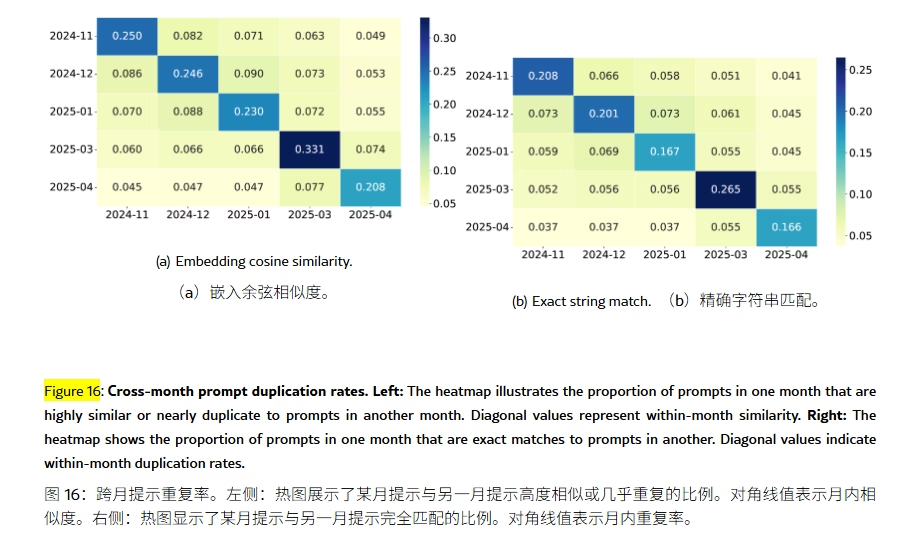

- 过拟合问题 虽然是盲测, 但是大部分用户聊天内容都大差不差, 导致模型厂商很容易针对这些聊天反复训练来刷分

总之, 如果真的想要投入大量资源使用大模型,我的加以还是最好自己构建一个符合自己场景的数据集,自己测测试试。

吃瓜地址:arxiv.org/html/2504.20879

0