微软研究院整了个活,发布了个原生 1-bit 的大语言模型 —— bitnet-b1.58-2B-4T

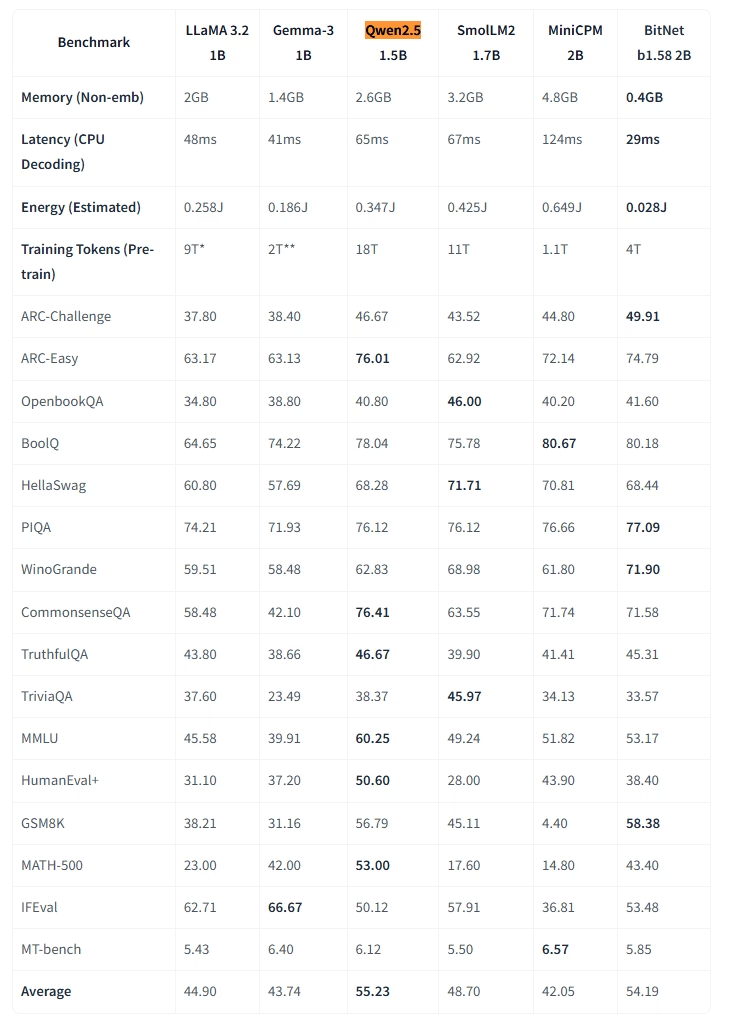

有啥意义吗?有的,这个模型虽然将权重量化到超低精度(实际是1.58位,权重只有{-1, 0, +1}三个值),但它在性能上几乎能与其它2B参数规模的全精度模型相媲美。

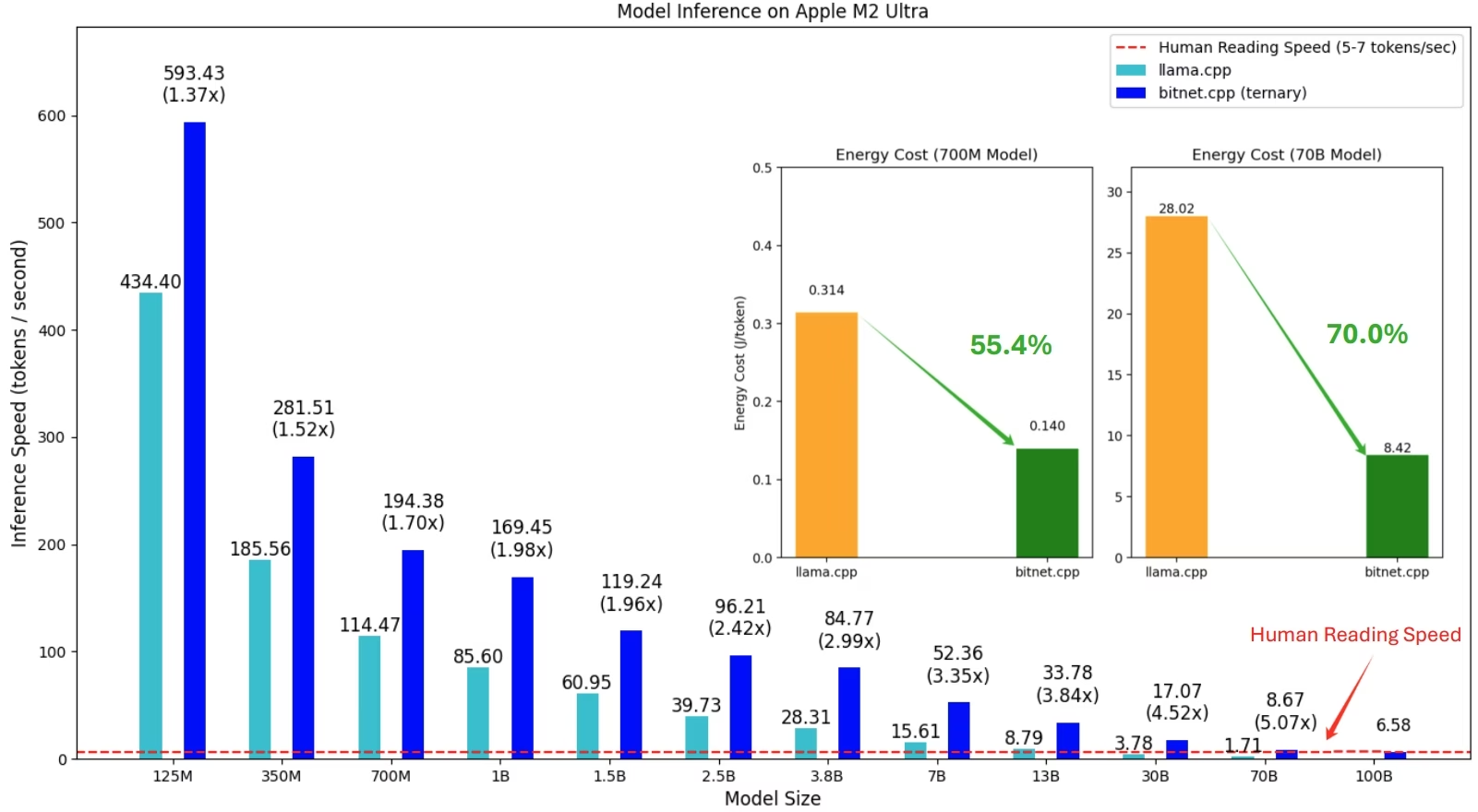

与传统模型相比,这个1-bit模型带来了惊人的效率提升:

- 内存占用只有0.4GB(其他同规模模型需要2-4.8GB)

- CPU推理延迟只有29ms(其他模型为41-124ms)

最厉害的是,这个模型不是后期量化的,而是从头就用1-bit精度训练的,在4万亿token上训练后,各项测试成绩平均达到54.19分,几乎与最佳的同类模型Qwen2.5-1.5B(55.23分)相当

这证明了低精度神经网络也能达到与全精度模型相当的效果,同时大幅提升效率,为轻量级AI应用(尤其是端侧)开辟了新可能

同时,这个模型有专门配套推理框架 BitNet,这个框架原生就是为CPU推理准备的

模型地址:huggingface.co/microsoft/bitnet-b1.58-2B-4T BitNet框架地址:github.com/microsoft/BitNet

0