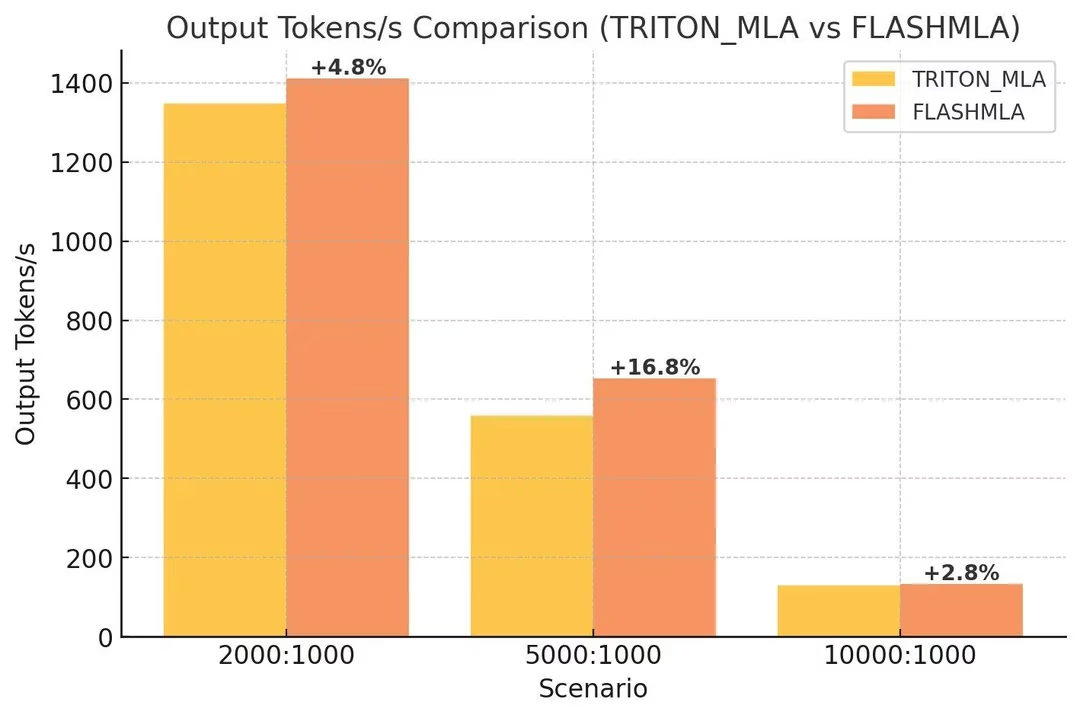

DeepSeek 开源的 FlashMLA已经合并到vLLM了,吞吐性能提高5%-10%,相对的会增加1%的延迟。感兴趣的同学可以试试了。

需要注意的是,目前只支持MLA model ,以及,这个改进目前只能用在Hopper架构的显卡上(H100,H200,H800).

PR详细地址:github.com/vllm-project/vllm/pull/13747

0

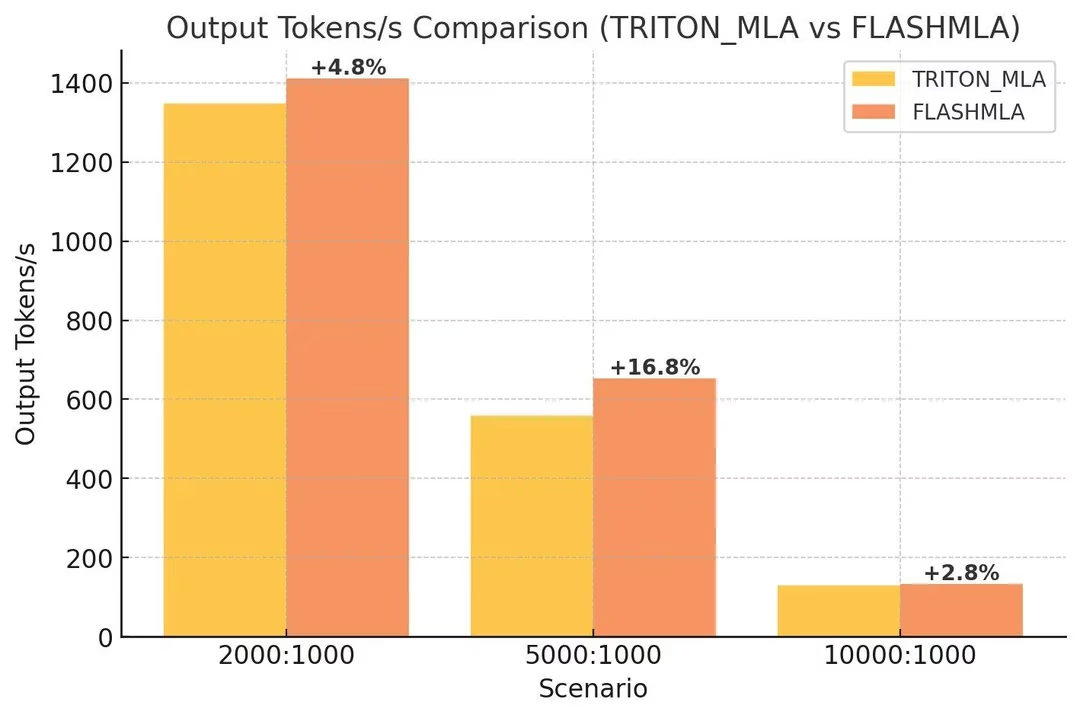

DeepSeek 开源的 FlashMLA已经合并到vLLM了,吞吐性能提高5%-10%,相对的会增加1%的延迟。感兴趣的同学可以试试了。

需要注意的是,目前只支持MLA model ,以及,这个改进目前只能用在Hopper架构的显卡上(H100,H200,H800).

PR详细地址:github.com/vllm-project/vllm/pull/13747