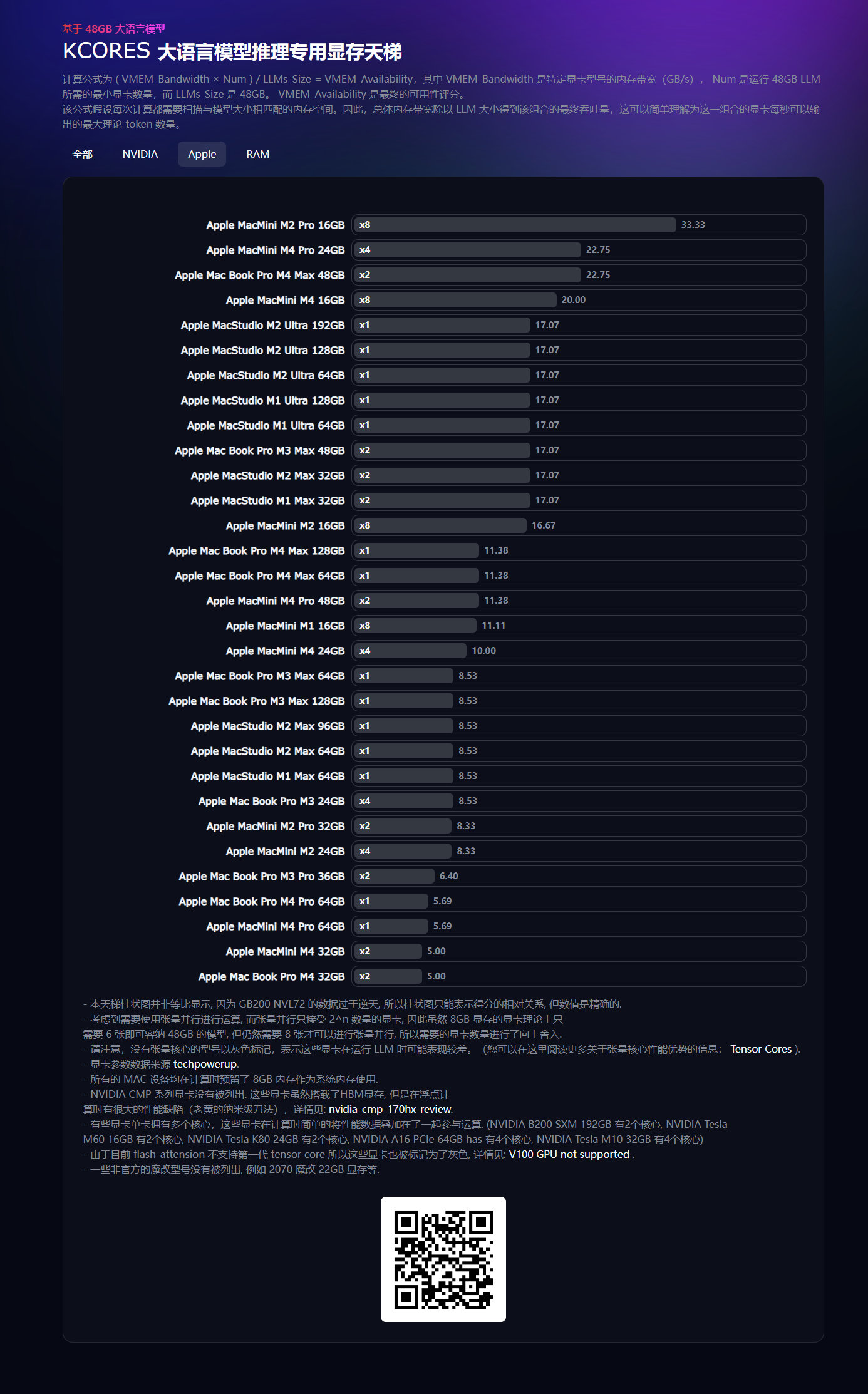

Apple MacMini M4 刚刚发布, 有很多朋友觉得跑 LLM(大语言模型) 或者炼丹等 AI 应用应该很性感, 我之前搞了个显存天梯, 刚刚更新了 M4 设备, 让我们来直接看天梯分数 (图1).

Apple MacMini M4 Pro 24GB x4 来到了 22.75 分, 这意味着什么呢? 这意味着 4 台 Apple MacMini M4 Pro 24GB 可以在运行 Llama-3.1-70b-instruct-4bit (3.3也一样, 只限制于模型大小, 版本无关) 模型时每秒钟生成 23 个 token (最大理论值, 实际还会更少).

如果问单机 M4 谁最强? 那还是 Apple MacBook Pro M4 Max 64GB, 每秒钟 11.38 个 token.

所以考虑AI专用的 Mac, 我的建议还是买 64GB 或以上的 MacStucio M1 Ultra 或 M2 Ultra 比较好 (我的 M2 Ultra 128GB 实测 13.9 token/s), 他们的内存速度达到了 800GB/s 而 M4 Pro 只有 273GB/s, 即使是 M4 Max 也只有 546GB/s (而且 Mac Mini 没有 Max 版本). 或者, 再等等 M4 Ultra 的 MacStudio.

如果就想买一台 64GB 的 MacMini M4 Pro 性能会怎样? 答案是 5.69 token/s.

最后, 想要看跑分? 点这里 https://vmem-for-llms.kcores.com/index-cn

实际上有很多问题没有考虑,比如首字回复速度。还有flash attention支持,FP8等等 🤪 。 vllm,sglang一票加速库甚至还不支持sm70/75的卡。

基本上只能用mlx跑, 我估计买的更注重去做周边应用, 而不是弄模型本身