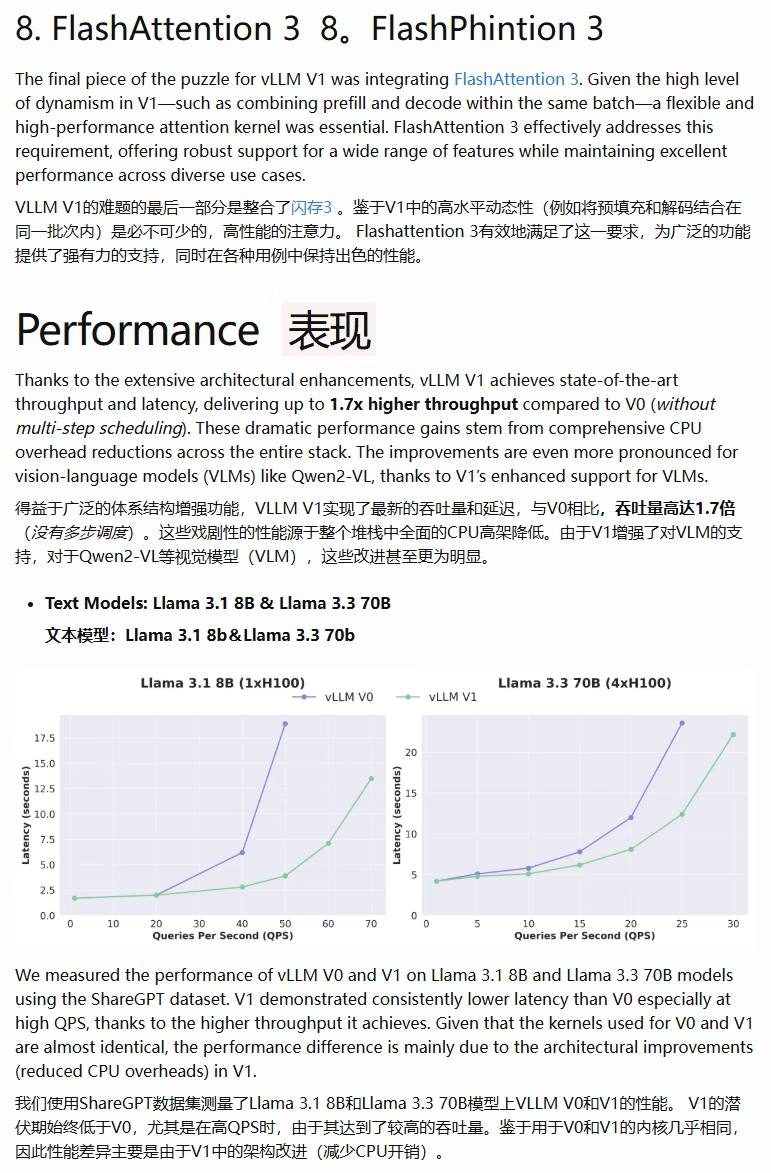

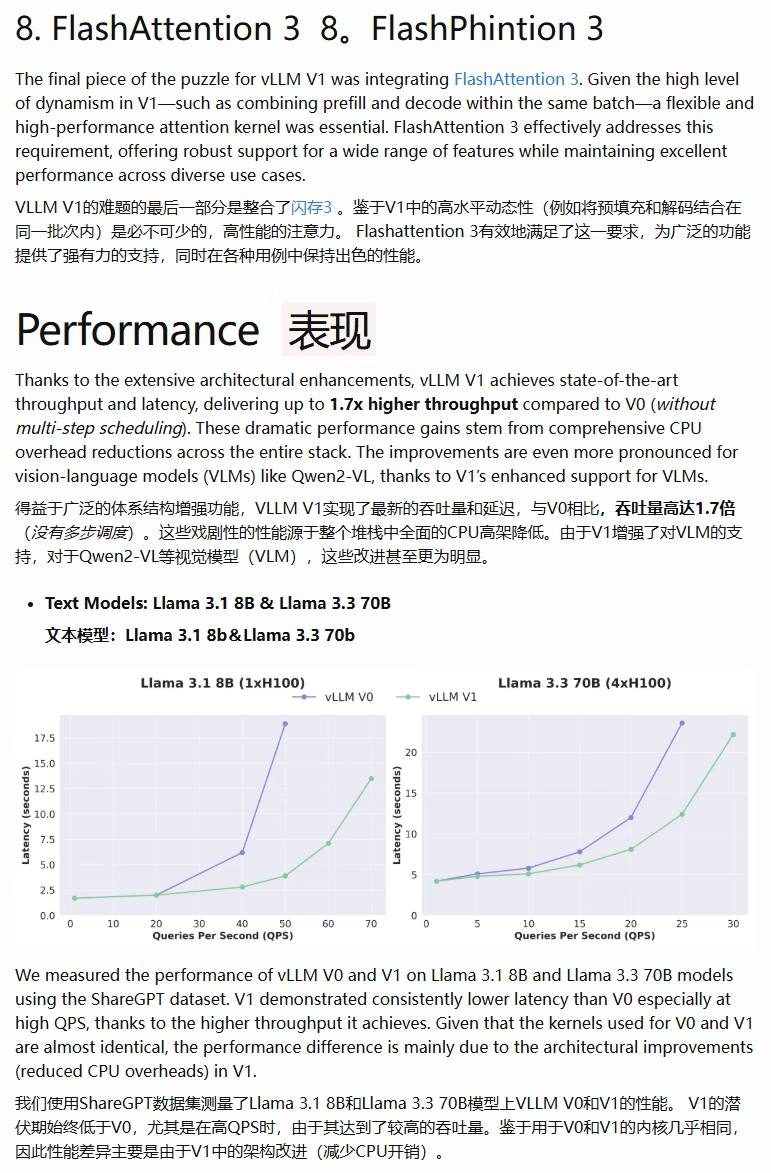

vLLM的最新v1架构中支持Flash Attention3了,整体性能优化后吞吐量提升到了1.7倍。显卡比较多的同学可以下载最新版本试试了

他们的更新说明:blog.vllm.ai/2025/01/27/v1-alpha-release.html

0

vLLM的最新v1架构中支持Flash Attention3了,整体性能优化后吞吐量提升到了1.7倍。显卡比较多的同学可以下载最新版本试试了

他们的更新说明:blog.vllm.ai/2025/01/27/v1-alpha-release.html